NPU là gì? Tìm hiểu khái niệm, cấu tạo, nguyên lý hoạt động và ứng dụng của NPU trong trí tuệ nhân tạo cùng ưu điểm nổi bật và xu hướng phát triển tương lai.

Introduction

Trong kỷ nguyên trí tuệ nhân tạo (AI là gì) bùng nổ như hiện nay, bạn có bao giờ tự hỏi điều gì làm cho các thiết bị thông minh ngày càng “thông minh” hơn không? Câu trả lời nằm ở một linh kiện nhỏ bé nhưng đầy quyền năng: NPU. Nhiều người dùng thường nghe đến CPU hay GPU, nhưng lại khá mơ hồ về thành phần mới nổi này. Sự nhầm lẫn giữa NPU với các bộ xử lý truyền thống khiến chúng ta khó nhận ra vai trò thực sự và sức mạnh đột phá mà nó mang lại cho công nghệ. Bài viết này của AZWEB sẽ là người bạn đồng hành, giúp bạn giải mã tất cả những thắc mắc đó một cách chi tiết và dễ hiểu nhất. Chúng ta sẽ cùng nhau tìm hiểu khái niệm NPU là gì, cấu tạo và nguyên lý hoạt động ra sao. Hơn thế nữa, bài viết sẽ đi sâu vào các ứng dụng thực tiễn, so sánh ưu điểm của NPU và phác thảo xu hướng phát triển đầy hứa hẹn trong tương lai.

Khái niệm và định nghĩa NPU

NPU là gì?

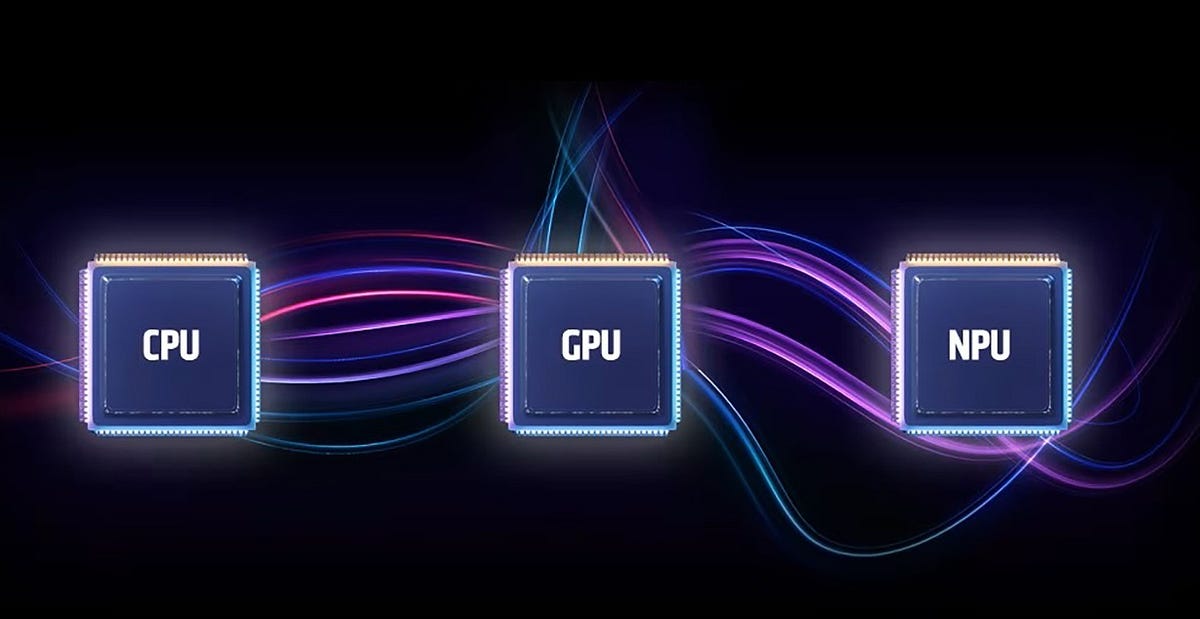

NPU, viết tắt của Neural Processing Unit (Bộ xử lý Thần kinh), là một bộ vi xử lý chuyên dụng được thiết kế riêng để tăng tốc các tác vụ liên quan đến trí tuệ nhân tạo (AI) và học máy (Machine Learning). Hãy hình dung NPU như một “bộ não chuyên biệt” cho AI. Trong khi CPU (Central Processing Unit) là bộ não tổng chỉ huy, xử lý đa dạng các công việc của hệ thống, và GPU (Graphics Processing Unit) là chuyên gia xử lý đồ họa, thì NPU được sinh ra chỉ để thực hiện một nhiệm vụ: xử lý các thuật toán mạng nơ-ron nhân tạo một cách hiệu quả nhất.

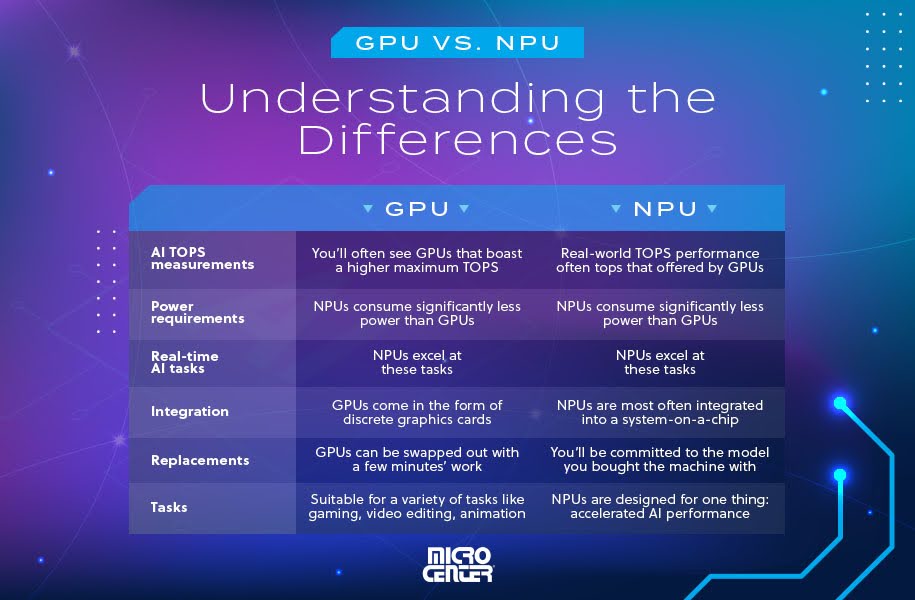

Chức năng chính của nó là thực hiện các phép tính ma trận và vector phức tạp, vốn là nền tảng của các mạng nơ-ron nhân tạo, với tốc độ cực nhanh và tiêu thụ ít năng lượng. Sự khác biệt cốt lõi nằm ở kiến trúc. CPU được thiết kế để xử lý tuần tự các tác vụ phức tạp, còn GPU được tối ưu cho việc xử lý song song hàng ngàn tác vụ đơn giản (như pixel trên màn hình). NPU thì đi xa hơn, nó được kiến tạo với hàng ngàn lõi nhỏ gọi là MAC (Multiply-Accumulate) chuyên biệt cho các phép tính nhân và cộng – hai phép toán cơ bản nhất trong mạng nơ-ron. Nhờ đó, nó có thể xử lý các mô hình AI với hiệu suất mà CPU và GPU khó có thể sánh bằng.

Vai trò của NPU trong công nghệ hiện đại

Trong bức tranh công nghệ hiện đại, vai trò của NPU không chỉ là một “bộ phận phụ” mà đã trở thành trung tâm xử lý cho các thuật toán AI. Nó đóng vai trò là động cơ tăng tốc, giúp các mô hình AI từ đơn giản đến phức tạp chạy mượt mà, nhanh chóng và hiệu quả hơn bao giờ hết, đặc biệt là trên các thiết bị có tài nguyên hạn chế như điện thoại thông minh hay thiết bị IoT. Vai trò này thể hiện rõ rệt qua hai khía cạnh chính: tối ưu hóa xử lý và tiết kiệm năng lượng.

Thứ nhất, NPU được kiến tạo để tối ưu hóa việc xử lý các mạng n-ron. Bằng cách gánh vác các công việc tính toán nặng nhọc của AI, NPU giải phóng cho CPU và GPU, cho phép chúng tập trung vào các nhiệm vụ khác như chạy ứng dụng hay hiển thị đồ họa. Điều này tạo ra một hệ thống hoạt động hài hòa và hiệu quả, nơi mỗi bộ xử lý thực hiện đúng công việc sở trường của mình. Thứ hai, và cũng không kém phần quan trọng, NPU giúp tiết kiệm năng lượng một cách đáng kể. Vì được thiết kế chuyên dụng, nó hoàn thành tác vụ AI với lượng điện năng tiêu thụ thấp hơn rất nhiều so với khi chạy trên CPU hay GPU. Đây là yếu tố cực kỳ quan trọng đối với các thiết bị di động, giúp kéo dài tuổi thọ pin và mang lại trải nghiệm người dùng tốt hơn.

Cấu tạo và nguyên lý hoạt động của NPU

Cấu tạo cơ bản của NPU

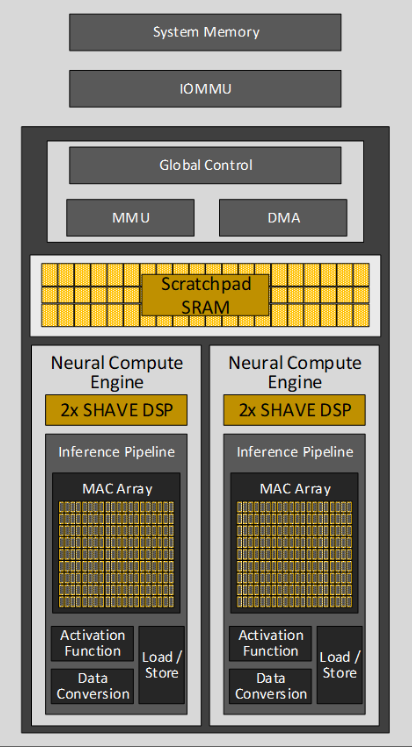

Để hiểu được tại sao NPU lại có sức mạnh xử lý AI vượt trội, chúng ta cần khám phá cấu tạo bên trong của nó. Không giống như kiến trúc đa dụng của CPU, cấu trúc của NPU được “may đo” đặc biệt cho một mục đích duy nhất: thực thi các mô hình mạng nơ-ron. Về cơ bản, một NPU bao gồm ba thành phần chính: các đơn vị tính toán ma trận (Matrix Multiply-Accumulate units), bộ nhớ đệm tốc độ cao (on-chip memory), và một đơn vị điều khiển thông minh.

Trái tim của NPU chính là một mảng lớn các đơn vị tính toán nhân-cộng (MAC). Đây là những lõi xử lý siêu nhỏ, được thiết kế để thực hiện phép nhân và phép cộng với hiệu suất cực cao. Một con chip NPU có thể chứa hàng ngàn, thậm chí hàng chục ngàn đơn vị MAC này hoạt động song song. Bên cạnh đó, NPU được trang bị bộ nhớ đệm (SRAM) ngay trên chip với băng thông rất lớn, giúp cung cấp dữ liệu cho các đơn vị MAC gần như tức thì, loại bỏ tình trạng nghẽn cổ chai thường thấy khi truy xuất dữ liệu từ bộ nhớ ngoài. Cuối cùng, đơn vị điều khiển sẽ điều phối dòng dữ liệu và luồng tính toán, đảm bảo toàn bộ hệ thống hoạt động một cách nhịp nhàng và hiệu quả nhất.

Nguyên lý hoạt động của NPU

Nguyên lý hoạt động của NPU dựa trên khả năng xử lý song song ở quy mô lớn và tối ưu hóa cho dòng chảy dữ liệu của mạng nơ-ron. Thay vì xử lý từng phép tính một cách tuần tự như CPU, NPU có thể thực hiện hàng triệu phép tính cùng một lúc, tương tự như cách các nơ-ron trong não người hoạt động đồng thời. Khi một mô hình AI được thực thi, ví dụ như nhận diện một hình ảnh, dữ liệu đầu vào (các pixel của ảnh) sẽ được chuyển đổi thành các ma trận số.

Các ma trận này sau đó được đưa vào NPU. Tại đây, đơn vị điều khiển sẽ phân chia chúng thành các phần nhỏ và gửi đến hàng ngàn đơn vị tính toán MAC. Mỗi đơn vị MAC sẽ thực hiện một phép tính nhân-cộng đơn giản, và kết quả từ tất cả các đơn vị sẽ được tổng hợp lại. Quá trình này được lặp lại qua nhiều lớp (layer) của mạng nơ-ron sâu (Deep Learning). Kiến trúc chuyên biệt này giúp giảm thiểu tối đa việc di chuyển dữ liệu không cần thiết và tối ưu hóa việc sử dụng năng lượng. Kết quả là NPU có thể hoàn thành các tác vụ suy luận AI trong một khoảng thời gian cực ngắn với hiệu quả năng lượng vượt trội.

Ứng dụng của NPU trong trí tuệ nhân tạo và học máy

Ứng dụng trong thiết bị di động và IoT

Sức mạnh của NPU đã và đang thay đổi cách chúng ta tương tác với các thiết bị công nghệ hàng ngày, đặc biệt là trong lĩnh vực di động và Internet vạn vật (IoT). Bạn có nhận thấy camera trên điện thoại thông minh ngày càng “ảo diệu” không? Đó chính là nhờ NPU. Nó giúp nhận diện cảnh vật theo thời gian thực để tự động điều chỉnh thông số, tối ưu hóa màu sắc, và tạo ra các hiệu ứng xóa phông chuyên nghiệp mà không cần đến máy ảnh cơ cồng kềnh. NPU cũng là động lực đằng sau tính năng “Night Mode”, giúp chụp ảnh sáng rõ trong điều kiện thiếu sáng bằng cách xử lý và kết hợp nhiều khung hình.

Ngoài camera, NPU còn là trái tim của các trợ lý ảo như Siri, Google Assistant. Nó cho phép thiết bị nhận diện và xử lý giọng nói của bạn ngay lập tức, ngay cả trong môi trường ồn ào, mà không cần phải gửi toàn bộ dữ liệu âm thanh lên máy chủ đám mây. Điều này không chỉ tăng tốc độ phản hồi mà còn bảo vệ quyền riêng tư của người dùng. Trong thế giới IoT, các thiết bị như chuông cửa thông minh hay camera an ninh cũng dựa vào NPU để phân tích hình ảnh, phát hiện chuyển động bất thường, nhận diện người quen và gửi cảnh báo đến bạn một cách thông minh, giảm thiểu các cảnh báo sai không cần thiết.

Ứng dụng trong trung tâm dữ liệu và máy chủ AI

Sức mạnh xử lý của NPU không chỉ giới hạn ở các thiết bị cá nhân nhỏ gọn. Trên quy mô lớn hơn, trong các trung tâm dữ liệu và hệ thống máy chủ, NPU (thường được gọi là AI accelerator) đóng vai trò là “động cơ tên lửa”, tăng tốc cho việc huấn luyện các mô hình AI phức tạp và xử lý khối lượng dữ liệu khổng lồ (Big Data). Việc huấn luyện một mô hình AI hiện đại, chẳng hạn như mô hình ngôn ngữ lớn, có thể mất hàng tuần hoặc hàng tháng nếu chỉ dùng CPU. Tuy nhiên, với các cụm máy chủ trang bị hàng trăm, hàng ngàn NPU, thời gian này có thể được rút ngắn đáng kể, chỉ còn vài ngày hoặc vài giờ.

Các dịch vụ AI trên nền tảng đám mây mà chúng ta sử dụng hàng ngày, như Google Translate, công cụ nhận dạng hình ảnh trong Google Photos, hay hệ thống gợi ý sản phẩm của Amazon, đều dựa vào các trang trại máy chủ (server farms) trang bị NPU. Chúng xử lý hàng tỷ yêu cầu mỗi ngày, từ dịch thuật văn bản, phân tích cảm xúc của khách hàng, đến chẩn đoán hình ảnh y tế. NPU giúp các công ty công nghệ cung cấp những dịch vụ AI này với tốc độ nhanh chóng, độ chính xác cao và chi phí vận hành hợp lý, từ đó thúc đẩy sự phát triển và phổ biến của trí tuệ nhân tạo trong mọi ngành nghề.

Ưu điểm khi sử dụng NPU so với các bộ xử lý truyền thống

Hiệu suất xử lý nâng cao

Ưu điểm nổi bật và dễ nhận thấy nhất của NPU chính là sự nhảy vọt về hiệu suất xử lý các tác vụ AI. So với CPU và GPU, vốn là các bộ xử lý đa dụng, NPU được thiết kế chuyên biệt để “ăn” và “thở” bằng các phép tính ma trận – nền tảng của mạng nơ-ron. Điều này cho phép nó hoàn thành các công việc liên quan đến AI nhanh hơn gấp nhiều lần, thậm chí hàng chục hoặc hàng trăm lần trong một số trường hợp cụ thể.

Hãy hình dung bạn cần dịch một cuốn sách dày. CPU giống như một người dịch thuật tỉ mỉ, dịch từng câu một cách tuần tự. GPU, với khả năng xử lý song song, giống như một đội ngũ dịch giả, mỗi người dịch một chương sách cùng lúc. Nhưng NPU thì giống như một siêu dịch giả có khả năng “quét” và thấu hiểu toàn bộ nội dung cuốn sách gần như ngay lập tức. Tốc độ vượt trội này giúp các ứng dụng AI phản hồi tức thì, mang lại trải nghiệm người dùng liền mạch và mượt mà. Ví dụ, tính năng nhận diện khuôn mặt để mở khóa điện thoại chỉ mất một phần nhỏ của giây, hay các hiệu ứng thực tế tăng cường (AR) được áp dụng trong thời gian thực mà không hề có độ trễ.

Tiết kiệm năng lượng và chi phí

Một nghịch lý thú vị của NPU là hiệu suất cao thường không đi đôi với tiêu thụ nhiều năng lượng. Ngược lại, tiết kiệm năng lượng chính là một trong những ưu điểm cốt lõi của nó. Vì được tối ưu hóa cho một loại công việc duy nhất, NPU hoàn thành nhiệm vụ với lượng điện năng tiêu thụ thấp hơn đáng kể so với khi CPU hay GPU phải gồng mình xử lý cùng một tác vụ AI. Kiến trúc chuyên dụng giúp nó loại bỏ các thành phần và hoạt động thừa thãi không cần thiết, tập trung toàn bộ tài nguyên vào việc tính toán nơ-ron.

Ưu điểm này đặc biệt quan trọng đối với các thiết bị di động và IoT, nơi mà thời lượng pin là yếu tố sống còn. Nhờ NPU, điện thoại của bạn có thể chạy các ứng dụng AI phức tạp cả ngày dài mà không lo hết pin. Ít tiêu thụ điện năng hơn cũng đồng nghĩa với việc tỏa nhiệt ít hơn. Điều này giúp thiết bị hoạt động mát mẻ, ổn định, và kéo dài tuổi thọ của các linh kiện bên trong. Trên quy mô lớn của các trung tâm dữ liệu, việc sử dụng NPU giúp giảm đáng kể hóa đơn tiền điện và chi phí cho các hệ thống làm mát phức tạp, từ đó tối ưu hóa chi phí vận hành cho các doanh nghiệp cung cấp dịch vụ AI.

Tương lai phát triển và xu hướng công nghệ NPU

Sự bùng nổ của AI và nhu cầu NPU

Tương lai của NPU gắn liền mật thiết với sự phát triển vũ bão của trí tuệ nhân tạo, và có thể nói rằng, tương lai đó vô cùng hứa hẹn. Khi AI ngày càng thâm nhập sâu vào mọi khía cạnh của đời sống, từ xe tự lái, trợ lý ảo thông minh, y tế chẩn đoán chính xác, đến các thành phố thông minh, nhu cầu về một bộ xử lý AI chuyên dụng, hiệu quả như NPU sẽ bùng nổ mạnh mẽ hơn bao giờ hết. Chúng ta đang bước vào một kỷ nguyên mà mọi thiết bị đều cần có khả năng xử lý AI tại chỗ (on-device AI) – một xu hướng quan trọng trong điện toán đám mây và data science.

Xu hướng này sẽ thúc đẩy việc tích hợp NPU không chỉ trong những chiếc smartphone cao cấp mà còn trong các sản phẩm tầm trung, các thiết bị đeo thông minh, đồ gia dụng, robot công nghiệp và hệ thống an ninh. Sự phổ biến rộng rãi này sẽ tạo ra một làn sóng đổi mới sáng tạo, cho phép các nhà phát triển tạo ra những ứng dụng AI thông minh hơn, cá nhân hóa hơn và hữu ích hơn, những thứ mà trước đây chúng ta chỉ có thể thấy trong các bộ phim khoa học viễn tưởng. NPU đang dần trở thành một thành phần tiêu chuẩn, không thể thiếu trong thế giới công nghệ.

Đổi mới công nghệ và tích hợp đa chức năng

Để đáp ứng nhu cầu ngày càng tăng, các nhà sản xuất chip hàng đầu thế giới không ngừng nghiên cứu và đổi mới công nghệ NPU. Các thế hệ NPU trong tương lai được dự đoán sẽ còn mạnh mẽ hơn, thông minh hơn và linh hoạt hơn. Một trong những xu hướng chính là tích hợp NPU sâu hơn với các công nghệ mới nổi như điện toán biên (Edge Computing). Điều này cho phép các thiết bị xử lý những mô hình AI phức tạp ngay tại chỗ mà không cần phải phụ thuộc vào kết nối internet hay máy chủ đám mây, giúp tăng tốc độ xử lý, giảm độ trễ và tăng cường bảo mật dữ liệu.

Bên cạnh đó, kiến trúc NPU cũng đang được cải tiến liên tục. Các nhà nghiên cứu đang hướng tới việc phát triển những con chip đa lõi NPU với khả năng tự học và tự tối ưu hóa. Những con chip này có thể tự động điều chỉnh cấu hình và phân bổ tài nguyên để phù hợp nhất với mô hình AI đang chạy, mang lại hiệu suất tối đa trong mọi tình huống. Hơn nữa, chúng ta cũng sẽ thấy sự kết hợp của NPU với các loại bộ xử lý chuyên dụng khác trên cùng một con chip (System-on-a-Chip), tạo ra những hệ thống xử lý toàn diện, có khả năng xử lý mọi loại tác vụ một cách hiệu quả nhất.

Common Issues/Troubleshooting

Vấn đề tương thích phần mềm với NPU

Mặc dù NPU mang lại sức mạnh xử lý ấn tượng, việc khai thác tối đa tiềm năng của nó không phải lúc nào cũng là một con đường trải đầy hoa hồng. Một trong những thách thức lớn nhất mà các nhà phát triển phải đối mặt là vấn đề tương thích phần mềm. Hiện tại, thị trường NPU khá phân mảnh, mỗi nhà sản xuất chip lớn như Apple, Qualcomm, Google hay Samsung lại có thiết kế kiến trúc NPU và bộ công cụ phát triển (SDK) riêng.

Điều này tạo ra một rào cản đáng kể. Để một ứng dụng AI có thể tận dụng hết sức mạnh của NPU trên các thiết bị khác nhau, các nhà phát triển phần mềm phải tốn rất nhiều thời gian và nguồn lực để tối ưu hóa mã nguồn của họ cho từng loại NPU cụ thể. Nếu không được tối ưu hóa đúng cách, ứng dụng AI có thể sẽ không chạy nhanh như kỳ vọng, hoặc tệ hơn là không thể sử dụng NPU mà phải chạy trên CPU/GPU, làm mất đi lợi thế về hiệu suất và năng lượng. Việc chuẩn hóa các API và framework chung cho NPU, như NNAPI của Android, là một bước đi đúng đắn nhưng vẫn cần thêm thời gian để trở nên hoàn thiện và phổ biến.

Giới hạn khả năng xử lý đối với các mô hình phức tạp

Một vấn đề thực tế khác của NPU, đặc biệt là các NPU được tích hợp trên thiết bị di động và IoT, là giới hạn về khả năng xử lý. Các con chip này được thiết kế để tạo ra sự cân bằng hoàn hảo giữa hiệu suất, năng lượng tiêu thụ và chi phí sản xuất. Do đó, chúng có thể gặp khó khăn hoặc không đủ mạnh để xử lý các mô hình AI có kiến trúc cực kỳ lớn, phức tạp hoặc đòi hỏi độ chính xác toán học rất cao.

Khi một tác vụ AI đòi hỏi khả năng tính toán vượt ngưỡng của NPU, chẳng hạn như huấn luyện một mô hình mới ngay trên thiết bị hoặc chạy đồng thời nhiều mô hình AI khác nhau, NPU có thể trở nên quá tải. Trong những tình huống này, gánh nặng xử lý có thể phải được chuyển trở lại cho GPU, hoặc được gửi lên các hệ thống máy chủ đám mây mạnh mẽ hơn để xử lý. Vì vậy, các nhà phát triển cần phải nhận thức rõ về giới hạn của phần cứng và lựa chọn hoặc thiết kế các mô hình AI (ví dụ như các phiên bản “Lite”) phù hợp với khả năng của NPU trên thiết bị mục tiêu.

Best Practices

Để khai thác tối đa sức mạnh và hiệu quả mà NPU mang lại, các nhà phát triển và người dùng cần tuân thủ một số nguyên tắc và thực hành tốt nhất. Việc này không chỉ giúp ứng dụng chạy nhanh hơn mà còn đảm bảo hệ thống hoạt động ổn định và tiết kiệm năng lượng.

- Sử dụng SDK và framework hỗ trợ NPU: Đây là bước quan trọng nhất. Để ứng dụng của bạn có thể “giao tiếp” và tận dụng NPU, hãy ưu tiên sử dụng các bộ công cụ phát triển phần mềm (SDK) và framework được thiết kế riêng cho mục đích này. Ví dụ, Core ML của Apple, NNAPI (Neural Networks API) của Android, hay TensorFlow Lite delegate là những công cụ mạnh mẽ giúp tự động phân bổ các tác vụ AI phù hợp lên NPU.

- Ưu tiên thiết kế mô hình AI phù hợp: Không phải mô hình AI nào cũng chạy tốt trên NPU. Các mô hình gọn nhẹ, được tối ưu hóa thông qua các kỹ thuật như lượng tử hóa (quantization) và cắt tỉa (pruning) thường mang lại hiệu quả cao nhất. Việc thiết kế mô hình phù hợp với kiến trúc NPU là chìa khóa để đạt được sự cân bằng tối ưu giữa độ chính xác, tốc độ và mức tiêu thụ năng lượng.

- Tránh tải quá nhiều tác vụ không liên quan lên NPU: Hãy để NPU làm đúng chuyên môn của nó là xử lý mạng nơ-ron. Tránh việc cố gắng giao các tác vụ xử lý thông thường, không liên quan đến AI cho NPU. Điều này không những không hiệu quả mà còn có thể làm giảm hiệu suất tổng thể của hệ thống. Hãy để CPU và GPU đảm nhiệm những công việc sở trường của chúng.

- Đảm bảo cập nhật firmware và driver mới nhất: Các nhà sản xuất thiết bị và chip thường xuyên phát hành các bản cập nhật firmware và driver. Những bản cập nhật này không chỉ vá lỗi bảo mật mà còn thường chứa những cải tiến quan trọng về hiệu suất và khả năng tương thích cho NPU. Việc duy trì hệ thống luôn được cập nhật sẽ giúp các ứng dụng AI của bạn chạy mượt mà và ổn định hơn.

Conclusion

Qua hành trình tìm hiểu chi tiết, có thể thấy NPU không còn là một khái niệm công nghệ xa vời mà đã trở thành một thành phần cốt lõi, một động lực mạnh mẽ thúc đẩy cuộc cách mạng trí tuệ nhân tạo. Nó là bộ vi xử lý chuyên dụng, được sinh ra để giải quyết các bài toán AI một cách hiệu quả nhất, mang lại hiệu suất xử lý vượt trội và khả năng tiết kiệm năng lượng đáng kinh ngạc so với các bộ xử lý truyền thống như CPU và GPU. Từ việc nâng cao chất lượng camera trên điện thoại đến việc tăng tốc các dịch vụ đám mây, NPU đang âm thầm thay đổi thế giới của chúng ta.

Đã đến lúc bạn tự mình trải nghiệm sức mạnh của trí tuệ nhân tạo hiện đại. Khi lựa chọn các thiết bị công nghệ tiếp theo, từ điện thoại, máy tính bảng đến các thiết bị nhà thông minh, hãy thử tìm hiểu và khám phá những sản phẩm được tích hợp NPU. Chắc chắn bạn sẽ ngạc nhiên về sự khác biệt trong tốc độ và sự thông minh mà nó mang lại cho trải nghiệm hàng ngày. Thế giới công nghệ luôn vận động không ngừng. Hãy cùng AZWEB tiếp tục theo dõi những xu hướng mới nhất về NPU và chuẩn bị sẵn sàng để ứng dụng sức mạnh của nó vào các giải pháp kinh doanh và sáng tạo trong tương lai. Kỷ nguyên AI chỉ mới thực sự bắt đầu.