Trong thời đại kỹ thuật số mà các ứng dụng dựa trên đám mây và container đang thống trị, Kubernetes đã nhanh chóng nổi lên như một công cụ không thể thiếu đối với các nhà phát triển và quản trị hệ thống. Nó được xem là tiêu chuẩn vàng trong việc điều phối container, giúp tự động hóa và đơn giản hóa nhiều quy trình phức tạp. Nhưng chính xác thì Kubernetes là gì và tại sao nó lại quan trọng đến vậy trong việc quản lý container và triển khai ứng dụng hiện đại? Nếu bạn đang tìm câu trả lời cho những thắc mắc này, bạn đã đến đúng nơi.

Bài viết này của AZWEB sẽ là kim chỉ nam, giúp bạn giải thích rõ ràng từ định nghĩa cơ bản, cách thức hoạt động, các tính năng cốt lõi, cho đến những lợi ích vượt trội mà Kubernetes mang lại. Chúng tôi sẽ đi sâu vào từng khía cạnh, từ kiến trúc nền tảng đến cách ứng dụng thực tế trong môi trường doanh nghiệp. Hơn nữa, bài viết cũng sẽ so sánh Kubernetes với các công cụ khác và cung cấp một hướng dẫn chi tiết để bạn có thể bắt đầu hành trình của mình với công nghệ mạnh mẽ này. Hãy cùng khám phá thế giới của Kubernetes và cách nó có thể thay đổi cách bạn xây dựng và vận hành ứng dụng.

Định nghĩa Kubernetes và nguyên tắc hoạt động

Để hiểu rõ sức mạnh của Kubernetes, trước tiên chúng ta cần nắm vững các khái niệm nền tảng và kiến trúc cốt lõi của nó. Đây là những viên gạch đầu tiên giúp bạn xây dựng một nền tảng kiến thức vững chắc.

Kubernetes là gì? Khái niệm cơ bản

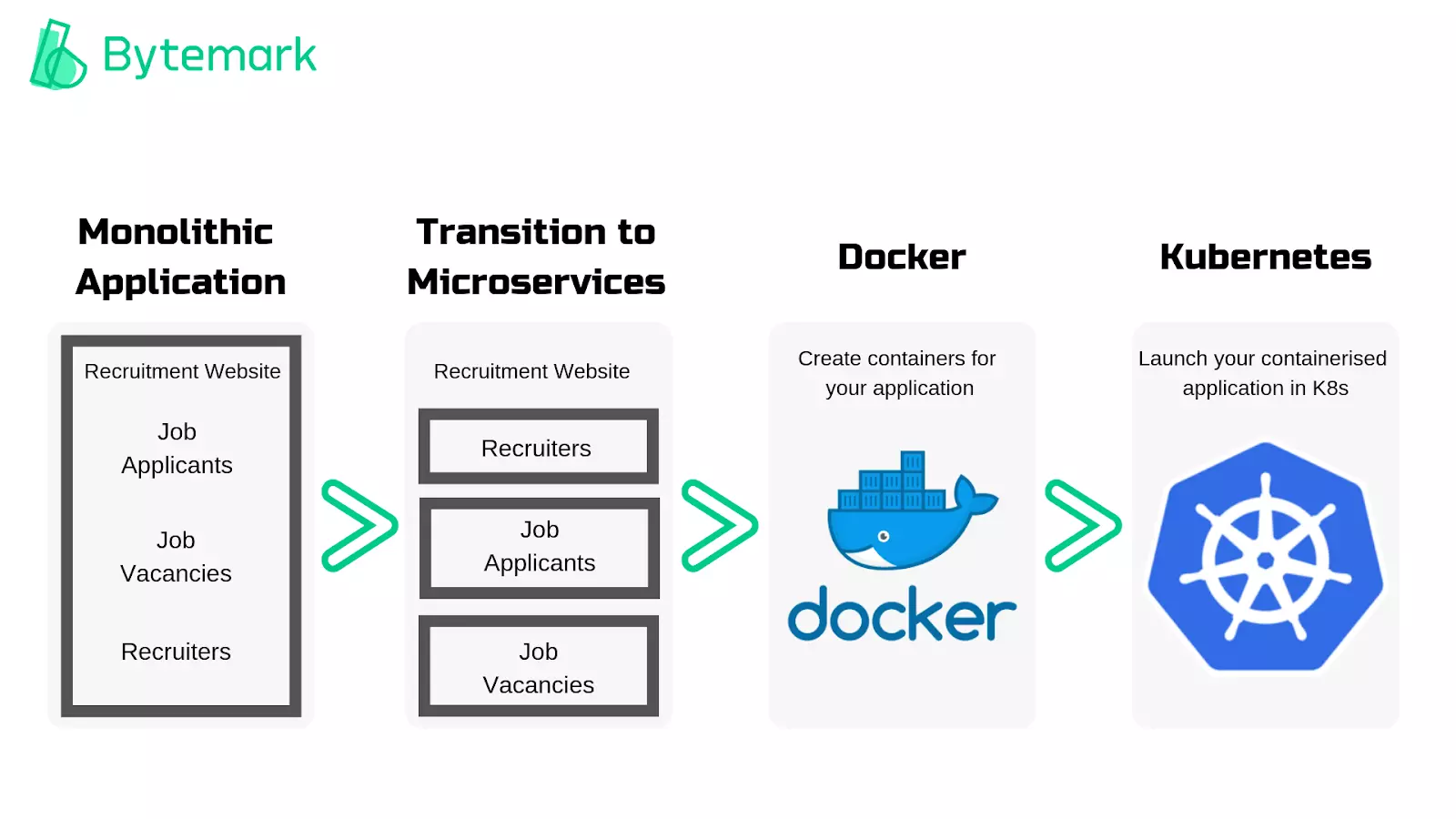

Kubernetes, thường được viết tắt là “K8s”, là một nền tảng mã nguồn mở dùng để tự động hóa việc triển khai, mở rộng và quản lý các ứng dụng được đóng gói trong container. Hãy tưởng tượng bạn là một nhạc trưởng của một dàn nhạc giao hưởng, và mỗi nhạc công là một container. Kubernetes chính là vị nhạc trưởng đó, đảm bảo rằng mọi nhạc công (container) đều chơi đúng lúc, đúng chỗ và phối hợp nhịp nhàng với nhau để tạo ra một bản giao hưởng hoàn hảo (ứng dụng của bạn). Nó không tự tạo ra container mà sẽ điều phối các container do các công cụ như Docker tạo ra. Ban đầu, Kubernetes được phát triển bởi Google dựa trên kinh nghiệm vận hành hàng tỷ container mỗi tuần của họ, sau đó được trao tặng cho Cloud Native Computing Foundation (CNCF). Nhờ sự hậu thuẫn mạnh mẽ từ cộng đồng, K8s đã trở thành tiêu chuẩn de facto trong ngành. Để hiểu rõ hơn về vai trò của ảo hóa trong việc tạo môi trường container, bạn cũng có thể tham khảo bài viết Ảo hóa là gì.

Kiến trúc và cách hoạt động của Kubernetes (Master Node, Worker Node, Pod, Container)

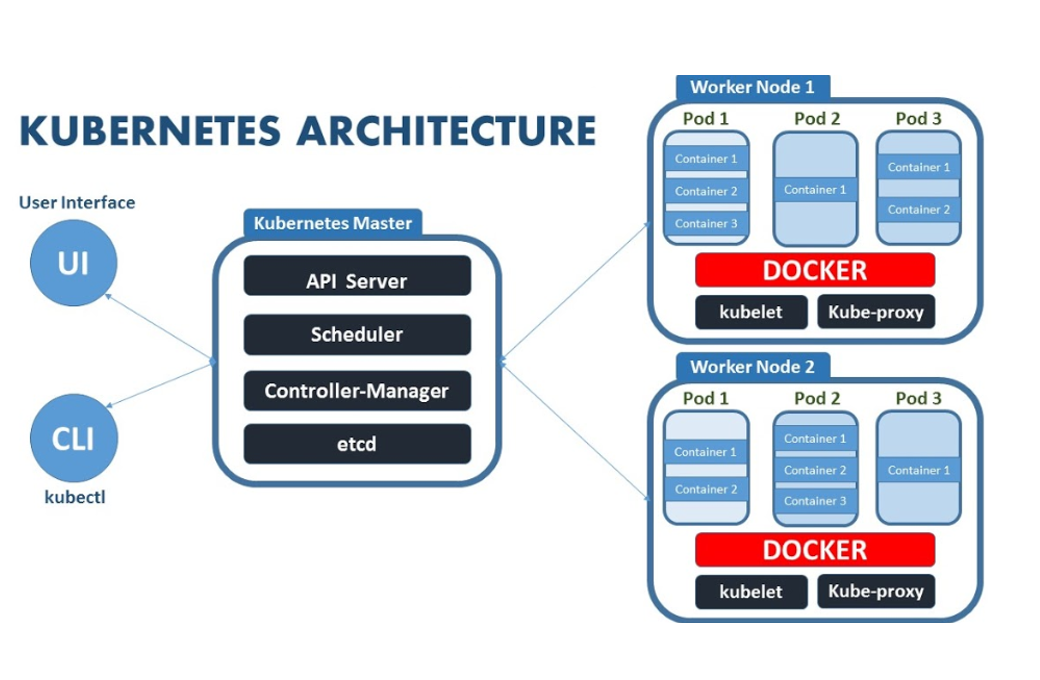

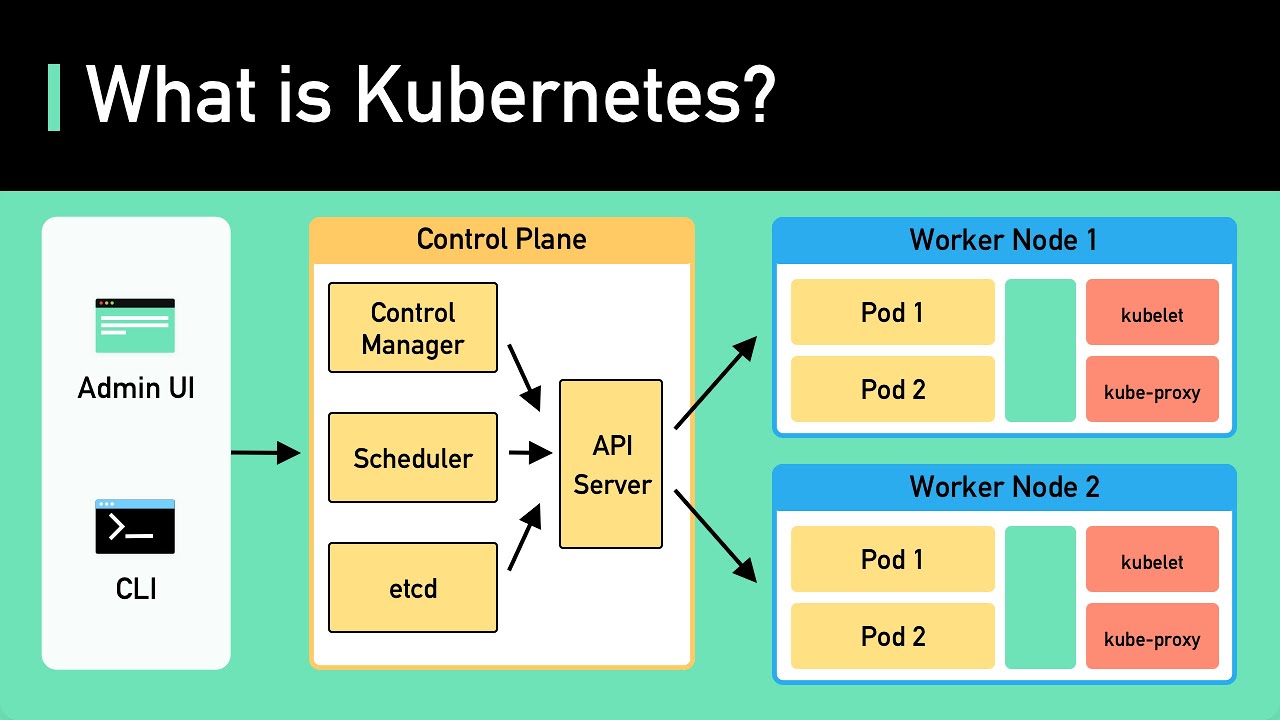

Hệ thống Kubernetes hoạt động dựa trên một kiến trúc client-server phân tán, bao gồm các thành phần chính phối hợp với nhau để duy trì trạng thái mong muốn của ứng dụng.

Về cơ bản, một cluster Kubernetes bao gồm hai loại máy chủ (nodes) chính:

- Master Node (Control Plane): Đây là bộ não của toàn bộ cluster. Nó chịu trách nhiệm đưa ra mọi quyết định toàn cục về cluster, chẳng hạn như lập lịch và phát hiện, phản ứng với các sự kiện của cluster. Các thành phần chính của Master Node bao gồm: API Server (cổng giao tiếp của hệ thống), etcd (kho lưu trữ key-value đáng tin cậy cho tất cả dữ liệu của cluster), Scheduler (phân công các Pod mới tạo vào các Worker Node phù hợp), và Controller Manager (chạy các tiến trình điều khiển). Bạn có thể tìm hiểu kiến thức nền tảng về máy ảo và ảo hóa để hiểu thêm về các loại máy chủ và ảo hóa tại bài viết Máy ảo là gì.

- Worker Node: Đây là nơi các ứng dụng của bạn thực sự chạy. Mỗi Worker Node chứa các dịch vụ cần thiết để chạy các Pod và được quản lý bởi Master Node. Các thành phần chính trên một Worker Node là Kubelet (giao tiếp với Master Node và đảm bảo các container được mô tả trong Pod đang chạy và khỏe mạnh), Kube-proxy (duy trì các quy tắc mạng trên node) và Container Runtime (phần mềm chịu trách nhiệm chạy container, ví dụ như Docker). Để hiểu thêm về các công cụ hỗ trợ chạy container, bạn có thể tham khảo phần giải thích về Vmware là gì trong việc quản lý máy ảo.

Các khái niệm cốt lõi khác bạn cần biết:

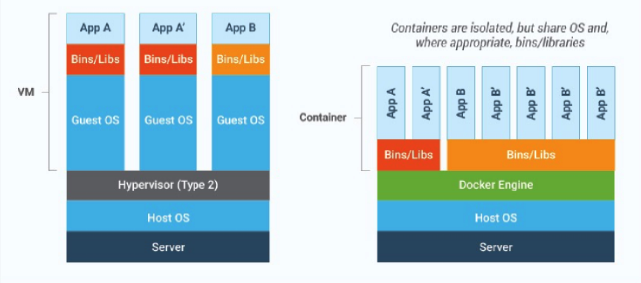

- Container: Một gói phần mềm nhẹ, độc lập, chứa mọi thứ cần thiết để chạy một phần của ứng dụng: code, runtime, công cụ hệ thống, thư viện và cài đặt.

- Pod: Là đơn vị nhỏ nhất có thể triển khai trong Kubernetes. Một Pod đại diện cho một nhóm gồm một hoặc nhiều container (chẳng hạn như Docker) và chia sẻ chung tài nguyên lưu trữ, mạng và các đặc tả về cách chạy các container đó. Các container trong cùng một Pod có thể giao tiếp với nhau qua `localhost`.

Khi bạn triển khai một ứng dụng, bạn sẽ tạo một file cấu hình (thường là YAML) để mô tả “trạng thái mong muốn”. Bạn gửi file này đến API Server trên Master Node. Master Node sẽ phân tích và Scheduler sẽ tìm một Worker Node phù hợp để chạy ứng dụng của bạn. Kubelet trên Worker Node đó sẽ nhận lệnh và khởi tạo Pod chứa các container cần thiết. Controller Manager sẽ liên tục theo dõi để đảm bảo trạng thái hiện tại của cluster khớp với trạng thái mong muốn bạn đã định nghĩa. Nếu bạn quan tâm tới việc sao lưu trạng thái hệ thống và dữ liệu, hãy xem qua bài viết Backup là gì để hiểu cách bảo vệ dữ liệu quan trọng.

Tính năng chính của Kubernetes trong quản lý container

Kubernetes không chỉ đơn thuần là một công cụ chạy container. Sức mạnh thực sự của nó nằm ở bộ tính năng phong phú, được thiết kế để tự động hóa và đơn giản hóa các tác vụ quản lý phức tạp, giúp các nhà phát triển tập trung vào việc xây dựng ứng dụng thay vì lo lắng về cơ sở hạ tầng.

Quản lý tự động container, Pods và dịch vụ

Một trong những tính năng nổi bật nhất của Kubernetes là khả năng tự động hóa vòng đời của container. Thay vì quản lý từng container một cách thủ công, bạn chỉ cần khai báo “trạng thái mong muốn” của ứng dụng thông qua các tệp cấu hình YAML hoặc JSON. Bạn định nghĩa rằng: “Tôi muốn chạy 3 bản sao của ứng dụng web này với phiên bản X”. Kubernetes sẽ nhận lấy yêu cầu đó và làm mọi thứ cần thiết để biến nó thành hiện thực. Nó sẽ tìm các node phù hợp, triển khai các Pod, và liên tục theo dõi để đảm bảo luôn có đủ 3 bản sao đang chạy. Nếu một Pod gặp sự cố và bị “chết”, Kubernetes sẽ tự động khởi tạo một Pod mới để thay thế mà không cần bất kỳ sự can thiệp nào từ con người. Quá trình này được gọi là “tự phục hồi” (self-healing), một trong những lợi ích cốt lõi giúp đảm bảo tính ổn định của hệ thống. Để hiểu thêm về cách thức quản lý và vận hành hệ thống, bạn có thể tham khảo thêm các bài viết về Proxmox là gì và Hypervisor là gì nhằm nắm rõ cách các nền tảng quản lý ảo hóa hỗ trợ công việc này.

Khả năng cân bằng tải và phát hiện dịch vụ (Service discovery & Load balancing)

Trong một môi trường microservices, các ứng dụng được chia thành nhiều dịch vụ nhỏ lẻ cần giao tiếp với nhau. Tuy nhiên, các Pod trong Kubernetes có thể bị hủy và tạo lại bất cứ lúc nào, dẫn đến địa chỉ IP của chúng liên tục thay đổi. Việc quản lý kết nối trong môi trường động như vậy là một thách thức lớn. Đây là lúc tính năng Service Discovery và Load Balancing của Kubernetes tỏa sáng. Kubernetes cung cấp một đối tượng gọi là “Service” để giải quyết vấn đề này. Một Service tạo ra một điểm truy cập (endpoint) ổn định và duy nhất cho một nhóm các Pod có cùng chức năng. Thay vì kết nối trực tiếp đến IP của Pod, các dịch vụ khác chỉ cần gọi đến tên DNS của Service. Kubernetes sẽ tự động ánh xạ yêu cầu đó đến một trong những Pod khỏe mạnh đang hoạt động phía sau. Đồng thời, nó cũng hoạt động như một bộ cân bằng tải (load balancer) cơ bản, phân phối lưu lượng truy cập mạng đều khắp các Pod, giúp ngăn ngừa tình trạng quá tải cho bất kỳ Pod đơn lẻ nào và cải thiện hiệu suất tổng thể của ứng dụng. Hãy xem thêm về các kỹ thuật lưu trữ và cân bằng tài nguyên như Raid là gì cũng góp phần quan trọng trong việc đảm bảo hạ tầng vận hành mượt mà.

Lợi ích khi sử dụng Kubernetes trong triển khai ứng dụng

Việc áp dụng Kubernetes không chỉ là một xu hướng công nghệ mà còn mang lại những lợi ích kinh doanh và kỹ thuật vô cùng to lớn. Nó giúp các tổ chức tăng tốc độ phát triển, cải thiện độ tin cậy của hệ thống và tối ưu hóa việc sử dụng tài nguyên.

Tự động hóa triển khai và quản lý ứng dụng

Lợi ích rõ ràng nhất khi sử dụng Kubernetes là mức độ tự động hóa mà nó mang lại. Các quy trình triển khai phần mềm truyền thống thường tốn nhiều thời gian, dễ xảy ra lỗi và đòi hỏi sự can thiệp thủ công đáng kể. Với Kubernetes, bạn có thể tự động hóa toàn bộ vòng đời ứng dụng, từ triển khai, cập nhật, cho đến gỡ bỏ. Bằng cách sử dụng các tệp khai báo, bạn có thể định nghĩa chính xác cách ứng dụng của mình nên chạy và để Kubernetes xử lý phần còn lại. Điều này giúp giảm thiểu sai sót do con người, tăng tốc độ đưa sản phẩm ra thị trường và cho phép đội ngũ DevOps tập trung vào các nhiệm vụ có giá trị cao hơn. Ví dụ, việc nâng cấp ứng dụng có thể được thực hiện một cách liền mạch thông qua các bản cập nhật cuốn chiếu (rolling updates), đảm bảo không có thời gian chết (downtime) ảnh hưởng đến người dùng. Để hiểu thêm về tự động hóa trong môi trường Windows, bạn có thể tham khảo bài viết Windows PowerShell là gì.

Khả năng mở rộng linh hoạt và đảm bảo tính sẵn sàng cao (High availability)

Trong thế giới kỹ thuật số luôn hoạt động, tính sẵn sàng cao không còn là một lựa chọn mà là một yêu cầu bắt buộc. Kubernetes được thiết kế từ đầu để xây dựng các hệ thống có khả năng phục hồi cao. Cơ chế tự phục hồi của nó đảm bảo rằng nếu một container hoặc Pod gặp sự cố, nó sẽ được khởi động lại hoặc thay thế ngay lập tức. Hơn nữa, Kubernetes có thể phân phối các bản sao của ứng dụng trên nhiều Worker Node khác nhau. Nếu một trong các Node gặp lỗi phần cứng hoặc ngừng hoạt động, Kubernetes sẽ tự động di chuyển các Pod đang chạy trên node đó sang các node khỏe mạnh khác, đảm bảo ứng dụng của bạn luôn sẵn sàng phục vụ người dùng. Bên cạnh đó, khả năng mở rộng cũng là một điểm cộng khổng lồ. Khi lưu lượng truy cập tăng đột biến, bạn có thể dễ dàng tăng số lượng bản sao của ứng dụng chỉ bằng một câu lệnh đơn giản hoặc thiết lập cơ chế tự động mở rộng, giúp hệ thống của bạn đáp ứng linh hoạt với mọi nhu cầu tải. Xem thêm về High availability là gì để hiểu sâu hơn về khái niệm này.

Cách Kubernetes hỗ trợ tự động hóa và mở rộng ứng dụng

Khả năng tự động hóa và mở rộng là hai trong số những lý do chính khiến Kubernetes trở thành lựa chọn hàng đầu cho các ứng dụng hiện đại. Hãy cùng tìm hiểu sâu hơn về cách K8s thực hiện những tác vụ này một cách thông minh và hiệu quả.

Tự động scaling (Horizontal Pod Autoscaling)

Một trong những tính năng mạnh mẽ nhất của Kubernetes là Horizontal Pod Autoscaling (HPA). Tính năng này cho phép cluster tự động điều chỉnh số lượng Pod trong một deployment, replication controller, hoặc stateful set dựa trên mức sử dụng tài nguyên thực tế như CPU hoặc bộ nhớ. Hãy tưởng tượng bạn đang vận hành một trang web thương mại điện tử. Vào những ngày bình thường, có thể bạn chỉ cần 3 Pod để xử lý lưu lượng truy cập. Tuy nhiên, trong một đợt khuyến mãi lớn, lượng người dùng tăng vọt. Thay vì phải can thiệp thủ công để thêm Pod và đối mặt với nguy cơ sập web, HPA sẽ tự động phát hiện sự gia tăng tải (ví dụ, CPU của các Pod hiện tại đã vượt quá 80%). Ngay lập tức, nó sẽ tạo thêm các Pod mới để phân산 tải. Khi đợt khuyến mãi kết thúc và lưu lượng truy cập trở lại bình thường, HPA cũng sẽ tự động giảm số lượng Pod xuống để tiết kiệm tài nguyên và chi phí. Cơ chế này đảm bảo ứng dụng của bạn luôn có hiệu suất tối ưu và khả năng đáp ứng linh hoạt với nhu cầu thay đổi của người dùng.

Rollout và rollback ứng dụng không gián đoạn

Việc cập nhật ứng dụng lên phiên bản mới luôn tiềm ẩn rủi ro. Một lỗi nhỏ trong mã nguồn mới có thể gây ra gián đoạn dịch vụ, ảnh hưởng đến trải nghiệm người dùng. Kubernetes giải quyết vấn đề này một cách xuất sắc thông qua các chiến lược triển khai thông minh, đặc biệt là “Rolling Update”. Khi bạn muốn triển khai một phiên bản mới, thay vì dừng tất cả các Pod cũ và khởi động các Pod mới cùng lúc (gây ra downtime), Kubernetes sẽ thực hiện quá trình này một cách từ từ. Nó sẽ thay thế từng Pod cũ bằng một Pod mới. Trong suốt quá trình cập nhật, dịch vụ của bạn vẫn luôn có các Pod đang hoạt động để phục vụ người dùng. Kubernetes sẽ chỉ tiếp tục cập nhật Pod tiếp theo khi Pod mới đã sẵn sàng và khỏe mạnh. Nếu có bất kỳ sự cố nào xảy ra với phiên bản mới, bạn có thể thực hiện “rollback” ngay lập tức. Chỉ với một câu lệnh, Kubernetes sẽ quay trở lại phiên bản ổn định trước đó một cách nhanh chóng và an toàn. Khả năng này giúp giảm thiểu rủi ro và mang lại sự tự tin cho các nhà phát triển khi triển khai các tính năng mới.

So sánh Kubernetes với các công cụ quản lý container khác

Kubernetes là công cụ điều phối container phổ biến nhất, nhưng không phải là duy nhất. Để có cái nhìn toàn diện, việc so sánh nó với các giải pháp khác như Docker Swarm và Apache Mesos là rất quan trọng, giúp bạn lựa chọn công cụ phù hợp nhất với nhu cầu của mình.

Kubernetes vs Docker Swarm

Docker Swarm là công cụ điều phối container được tích hợp sẵn trong Docker Engine. Đây là đối thủ cạnh tranh trực tiếp và gần gũi nhất với Kubernetes. Sự khác biệt chính nằm ở triết lý và độ phức tạp. Docker Swarm nổi bật với sự đơn giản và dễ sử dụng. Việc thiết lập một cluster Swarm nhanh hơn và yêu cầu ít cấu hình hơn đáng kể so với Kubernetes. Nếu bạn đã quen thuộc với hệ sinh thái Docker, việc chuyển sang Swarm là một bước đi tự nhiên. Nó rất phù hợp cho các ứng dụng nhỏ đến trung bình, nơi sự đơn giản và tốc độ triển khai được ưu tiên. Ngược lại, Kubernetes phức tạp hơn trong việc cài đặt và quản lý ban đầu. Tuy nhiên, sự phức tạp này đi kèm với sức mạnh và sự linh hoạt vượt trội. Kubernetes cung cấp một hệ sinh thái rộng lớn, cộng đồng hỗ trợ mạnh mẽ và bộ tính năng toàn diện hơn, bao gồm tự động mở rộng nâng cao, kiểm tra sức khỏe tùy chỉnh và khả năng quản lý lưu trữ, mạng phức tạp. Đối với các hệ thống lớn, yêu cầu tính sẵn sàng cao và khả năng mở rộng linh hoạt, Kubernetes thường là lựa chọn tối ưu và được coi là tiêu chuẩn của ngành.

Kubernetes vs Apache Mesos

Apache Mesos có một cách tiếp cận khác biệt so với Kubernetes và Docker Swarm. Mesos không phải là một công cụ điều phối container thuần túy, mà là một trình quản lý tài nguyên cluster tổng quát. Nó hoạt động ở một tầng thấp hơn, có nhiệm vụ trừu tượng hóa tài nguyên CPU, bộ nhớ, lưu trữ của các máy trong cluster và cung cấp chúng cho các “framework” chạy bên trên. Marathon, một framework phổ biến, thường được sử dụng cùng với Mesos để thực hiện việc điều phối container, tạo thành một giải pháp tương tự Kubernetes. Ưu điểm của Mesos là khả năng chạy nhiều loại workload khác nhau trên cùng một cluster, không chỉ container mà còn cả các ứng dụng Big Data như Hadoop hay Spark. Điều này làm cho nó trở nên cực kỳ linh hoạt cho các môi trường hạ tầng đa dạng. Tuy nhiên, việc thiết lập và vận hành một cluster Mesos cùng với Marathon thường phức tạp hơn Kubernetes. Kubernetes, mặt khác, được thiết kế chuyên biệt cho việc điều phối container. Nó cung cấp một giải pháp “có chính kiến” (opinionated) và tích hợp sẵn mọi thứ bạn cần, từ lập lịch, phát hiện dịch vụ đến cân bằng tải, giúp trải nghiệm người dùng liền mạch hơn cho các tác vụ liên quan đến container.

Ứng dụng thực tiễn của Kubernetes trong môi trường doanh nghiệp

Kubernetes đã vượt ra ngoài vai trò là một công cụ công nghệ để trở thành một yếu tố chiến lược, giúp các doanh nghiệp hiện đại hóa ứng dụng, tăng tốc độ đổi mới và vận hành hệ thống một cách hiệu quả hơn trên quy mô lớn.

Triển khai microservices và DevOps

Kubernetes và kiến trúc microservices dường như được sinh ra để dành cho nhau. Trong kiến trúc microservices, một ứng dụng lớn được chia thành nhiều dịch vụ nhỏ, độc lập. Mỗi dịch vụ có thể được phát triển, triển khai và mở rộng riêng biệt. Kubernetes cung cấp một nền tảng lý tưởng để quản lý sự phức tạp này. Mỗi microservice có thể được đóng gói vào một hoặc nhiều Pod, và Kubernetes sẽ đảm nhiệm việc triển khai, kết nối mạng và mở rộng chúng một cách tự động. Điều này hoàn toàn phù hợp với văn hóa DevOps. Các nhóm phát triển có thể tự chủ trong việc xây dựng và vận hành các dịch vụ của mình. Với Kubernetes, họ có thể dễ dàng tích hợp vào các đường ống CI/CD (Tích hợp liên tục/Triển khai liên tục), tự động hóa quá trình từ việc viết mã nguồn đến khi triển khai lên môi trường production. Kết quả là chu kỳ phát triển được rút ngắn, khả năng phản ứng với thay đổi của thị trường nhanh hơn và việc cộng tác giữa các nhóm phát triển (Dev) và vận hành (Ops) trở nên liền mạch. Nếu bạn quan tâm đến việc quản lý hiệu quả các công cụ và công việc, hãy tham khảo bài viết về Phần mềm quản lý công việc.

Quản lý hệ thống phức tạp và đa đám mây (Multi-cloud)

Khi các doanh nghiệp phát triển, cơ sở hạ tầng của họ ngày càng trở nên phức tạp. Họ có thể sử dụng dịch vụ từ nhiều nhà cung cấp đám mây khác nhau (như AWS, Google Cloud, Azure) hoặc kết hợp giữa đám mây công cộng và trung tâm dữ liệu tại chỗ (on-premise) – một chiến lược được gọi là hybrid cloud hoặc multi-cloud. Một trong những thách thức lớn nhất của chiến lược này là sự thiếu nhất quán giữa các môi trường. Kubernetes giải quyết vấn đề này bằng cách cung cấp một lớp trừu tượng hóa đồng nhất. Bất kể ứng dụng của bạn chạy trên nền tảng nào, bạn đều có thể quản lý chúng bằng cùng một bộ API và công cụ của Kubernetes. Điều này giúp tránh tình trạng “vendor lock-in” (bị phụ thuộc vào một nhà cung cấp duy nhất), cho phép doanh nghiệp di chuyển workload giữa các đám mây một cách linh hoạt để tối ưu hóa chi phí và hiệu suất. Khả năng quản lý một hệ thống phân tán phức tạp trên nhiều môi trường khác nhau từ một giao diện duy nhất là một lợi thế cạnh tranh vô cùng lớn mà Kubernetes mang lại. Để hiểu rõ thêm về quản lý hạ tầng và trung tâm dữ liệu, bạn có thể đọc bài Trung tâm dữ liệu là gì.

Hướng dẫn bắt đầu với Kubernetes

Bắt đầu hành trình với Kubernetes có thể có vẻ khó khăn lúc đầu, nhưng với các công cụ phù hợp và một lộ trình rõ ràng, bạn hoàn toàn có thể nắm vững công nghệ này. Dưới đây là các bước đầu tiên để bạn cài đặt và triển khai ứng dụng của mình.

Cài đặt Kubernetes trên môi trường local hoặc cloud

Trước khi có thể triển khai ứng dụng, bạn cần có một cluster Kubernetes đang hoạt động. Có hai cách tiếp cận chính:

- Cài đặt trên môi trường local (máy tính cá nhân): Đây là cách tuyệt vời để học tập, thử nghiệm và phát triển mà không tốn chi phí. Các công cụ phổ biến giúp bạn tạo một cluster Kubernetes mini trên máy của mình bao gồm:

- Minikube: Tạo một cluster Kubernetes chỉ với một node duy nhất bên trong một máy ảo (VM). Đây là lựa chọn cổ điển và phổ biến nhất cho người mới bắt đầu. Nếu bạn muốn hiểu rõ khái niệm máy ảo phục vụ cài đặt, hãy xem Máy ảo là gì.

- Kind (Kubernetes in Docker): Sử dụng các container Docker để mô phỏng các node Kubernetes. Nó khởi động nhanh hơn Minikube và rất hữu ích cho việc thử nghiệm CI/CD.

- Docker Desktop: Nếu bạn đang dùng Docker Desktop trên Windows hoặc macOS, bạn có thể kích hoạt một cluster Kubernetes chỉ với một cú nhấp chuột trong phần cài đặt. Đây là cách đơn giản nhất để bắt đầu.

- Sử dụng dịch vụ Kubernetes trên cloud: Khi bạn sẵn sàng triển khai ứng dụng cho môi trường production, việc sử dụng các dịch vụ Kubernetes được quản lý (managed Kubernetes services) là lựa chọn hàng đầu. Các nhà cung cấp đám mây lớn sẽ lo việc quản lý Master Node (Control Plane), giúp bạn tập trung vào ứng dụng của mình. Các dịch vụ phổ biến bao gồm:

- Google Kubernetes Engine (GKE): Dịch vụ của Google, cha đẻ của Kubernetes.

- Amazon Elastic Kubernetes Service (EKS): Dịch vụ của AWS.

- Azure Kubernetes Service (AKS): Dịch vụ của Microsoft Azure.

Đối với người mới, AZWEB khuyên bạn nên bắt đầu với Docker Desktop hoặc Minikube để làm quen với các khái niệm cơ bản.

Triển khai ứng dụng đầu tiên trên Kubernetes (Hello World example)

Sau khi có cluster, hãy cùng triển khai một ứng dụng đơn giản. Chúng ta sẽ thực hiện theo các bước sau:

- Chuẩn bị ứng dụng và Dockerfile: Viết một ứng dụng web đơn giản (ví dụ: bằng Node.js) chỉ để hiển thị “Hello World”. Sau đó, tạo một `Dockerfile` để đóng gói ứng dụng này thành một Docker image.

- Build và Push Docker Image: Sử dụng lệnh `docker build` để tạo image, sau đó đẩy (push) nó lên một kho lưu trữ image như Docker Hub hoặc Google Container Registry.

- Viết file cấu hình Deployment: Tạo một file YAML, ví dụ `deployment.yaml`, để định nghĩa một đối tượng `Deployment`. Trong file này, bạn sẽ chỉ định image nào cần dùng, số lượng bản sao (replicas) mong muốn (ví dụ: 2), và các thông tin khác.

- Áp dụng cấu hình Deployment: Mở terminal và chạy lệnh `kubectl apply -f deployment.yaml`. `kubectl` là công cụ dòng lệnh chính để tương tác với cluster Kubernetes. Lệnh này sẽ yêu cầu Kubernetes tạo các Pod dựa trên định nghĩa của bạn.

- Viết file cấu hình Service: Để truy cập ứng dụng từ bên ngoài, bạn cần tạo một `Service`. Tạo một file YAML khác, ví dụ `service.yaml`, để định nghĩa một đối tượng `Service` loại `LoadBalancer` hoặc `NodePort`. Service này sẽ chuyển tiếp lưu lượng truy cập đến các Pod mà bạn đã tạo ở bước trên.

- Áp dụng cấu hình Service: Chạy lệnh `kubectl apply -f service.yaml`.

- Kiểm tra và truy cập ứng dụng: Sử dụng lệnh `kubectl get pods` để xem các Pod của bạn có đang chạy không và `kubectl get services` để lấy địa chỉ IP và cổng để truy cập ứng dụng “Hello World” của bạn trên trình duyệt.

Chúc mừng! Bạn đã vừa triển khai thành công ứng dụng đầu tiên của mình trên Kubernetes. Đây là bước khởi đầu quan trọng để khám phá sâu hơn về sức mạnh của nền tảng này.

Common Issues/Troubleshooting

Trong quá trình làm việc với Kubernetes, việc gặp phải lỗi là điều không thể tránh khỏi. Hiểu rõ các sự cố phổ biến và cách khắc phục chúng là một kỹ năng quan trọng giúp bạn vận hành hệ thống một cách trơn tru.

Lỗi khi khởi động Pod hoặc Container không chạy

Đây là một trong những vấn đề thường gặp nhất, đặc biệt với người mới. Khi bạn triển khai một Pod nhưng nó không chuyển sang trạng thái `Running`, có một vài nguyên nhân phổ biến. Trạng thái của Pod sẽ cho bạn manh mối đầu tiên. Bạn có thể kiểm tra trạng thái bằng lệnh `kubectl get pods`.

- `ImagePullBackOff` hoặc `ErrImagePull`: Lỗi này có nghĩa là Kubernetes không thể kéo (pull) Docker image mà bạn đã chỉ định. Các nguyên nhân có thể là: sai tên image hoặc tag, image không tồn tại trên repository, hoặc cluster không có quyền truy cập vào một repository riêng tư. Để khắc phục, hãy kiểm tra lại tên image và đảm bảo bạn đã cấu hình `ImagePullSecrets` nếu cần.

- `CrashLoopBackOff`: Lỗi này cho biết container bên trong Pod đã khởi động nhưng ngay lập tức bị lỗi (crash), và Kubernetes đang cố gắng khởi động lại nó một cách vô vọng. Đây thường là lỗi từ chính ứng dụng của bạn, chẳng hạn như lỗi cú pháp, không thể kết nối đến cơ sở dữ liệu, hoặc cấu hình sai. Để tìm nguyên nhân, hãy sử dụng lệnh `kubectl logs <pod-name>` để xem log của container. Lệnh `kubectl describe pod <pod-name>` cũng cung cấp thông tin chi tiết về các sự kiện liên quan đến Pod.

- `Pending`: Nếu một Pod bị kẹt ở trạng thái `Pending` quá lâu, thường là do vấn đề về tài nguyên. Có thể cluster không còn đủ CPU hoặc bộ nhớ để cấp cho Pod, hoặc không có node nào thỏa mãn các yêu cầu (constraints) mà bạn đã đặt ra. Sử dụng `kubectl describe pod <pod-name>` để xem thông báo lỗi chi tiết từ Scheduler.

Sự cố về networking và load balancing

Mạng trong Kubernetes là một chủ đề phức tạp và là nguồn gốc của nhiều sự cố khó chẩn đoán. Các vấn đề thường xoay quanh việc giao tiếp giữa các Pod hoặc truy cập dịch vụ từ bên ngoài cluster.

- Pod không thể giao tiếp với nhau: Nếu các Pod không thể kết nối với nhau qua mạng nội bộ, hãy kiểm tra Network Policy. Có thể bạn đã vô tình tạo ra một chính sách mạng chặn lưu lượng truy cập cần thiết. Ngoài ra, hãy đảm bảo rằng CNI (Container Network Interface) plugin của bạn (như Calico, Flannel) đang hoạt động chính xác.

- Không thể truy cập Service từ bên ngoài: Khi bạn tạo một Service (ví dụ loại `LoadBalancer` hoặc `NodePort`) nhưng không thể truy cập được, hãy kiểm tra kỹ các bộ chọn (selectors) trong file cấu hình Service. Selector phải khớp chính xác với các nhãn (labels) của các Pod mà bạn muốn Service đó nhắm đến. Sử dụng lệnh `kubectl describe service <service-name>` để xem Service có đang trỏ đến đúng các Endpoints (địa chỉ IP của Pod) hay không. Nếu Endpoints trống, nghĩa là selector của bạn đã bị sai.

- Sự cố với Ingress: Ingress là đối tượng quản lý truy cập từ bên ngoài vào các Service trong cluster. Nếu Ingress không hoạt động, hãy kiểm tra xem Ingress Controller (như NGINX Ingress Controller, Traefik) đã được cài đặt và đang chạy đúng cách chưa. Kiểm tra log của Ingress Controller và cấu hình Ingress resource để tìm lỗi cú pháp hoặc quy tắc định tuyến sai.

Best Practices

Để tận dụng tối đa sức mạnh của Kubernetes và duy trì một hệ thống ổn định, an toàn và dễ quản lý, việc tuân thủ các thực hành tốt nhất (best practices) là vô cùng cần thiết. Dưới đây là những khuyến nghị quan trọng từ AZWEB.

- Luôn viết cấu hình YAML rõ ràng, chính xác: Các tệp YAML là trung tâm của việc quản lý Kubernetes. Hãy giữ cho chúng có cấu trúc tốt, dễ đọc và được quản lý trong hệ thống kiểm soát phiên bản như Git. Sử dụng chú thích (comments) để giải thích các lựa chọn cấu hình phức tạp. Việc này không chỉ giúp bạn trong tương lai mà còn giúp các thành viên khác trong nhóm dễ dàng hiểu và cộng tác.

- Sử dụng namespaces để quản lý tài nguyên hiệu quả: Đừng triển khai mọi thứ vào namespace `default`. Namespaces là một cách để tạo ra các không gian làm việc ảo trong cùng một cluster vật lý. Hãy tạo các namespace riêng biệt cho các môi trường khác nhau (ví dụ: `dev`, `staging`, `production`) hoặc cho các đội ngũ, dự án khác nhau. Điều này giúp tránh xung đột tên tài nguyên, quản lý quyền truy cập (RBAC) dễ dàng hơn và áp dụng các giới hạn tài nguyên (ResourceQuotas) cho từng không gian làm việc. Bạn có thể tham khảo thêm về các hệ điều hành Hệ điều hành Linux và Windows Server là gì để hỗ trợ việc quản lý môi trường hiệu quả hơn.

- Không nên để container chạy quyền root: Mặc định, các tiến trình trong container chạy với quyền root, đây là một rủi ro bảo mật lớn. Nếu một kẻ tấn công chiếm được quyền kiểm soát container, họ có thể có quyền truy cập root vào Worker Node. Hãy cấu hình `SecurityContext` trong Pod spec của bạn để chỉ định rằng container sẽ chạy với một người dùng không phải root.

- Thường xuyên cập nhật và backup dữ liệu cluster: Cộng đồng Kubernetes phát hành các phiên bản mới khoảng 3-4 tháng một lần với các bản vá lỗi và cập nhật bảo mật quan trọng. Hãy lên kế hoạch để cập nhật cluster của bạn một cách thường xuyên. Quan trọng không kém là việc sao lưu (backup) trạng thái của cluster. Dữ liệu cấu hình của toàn bộ cluster được lưu trong `etcd`. Hãy sử dụng các công cụ như Velero để sao lưu `etcd` và các persistent volume một cách định kỳ, đề phòng trường hợp xảy ra thảm họa. Tham khảo thêm về Backup là gì để biết kỹ thuật sao lưu hiệu quả.

Conclusion

Qua hành trình khám phá từ những khái niệm cơ bản đến các ứng dụng phức tạp, có thể thấy rõ Kubernetes không chỉ là một công cụ công nghệ mà còn là một nền tảng chiến lược, định hình lại cách chúng ta xây dựng, triển khai và vận hành ứng dụng trong kỷ nguyên số. Tóm lại, Kubernetes là một công cụ điều phối container cực kỳ mạnh mẽ, giúp tự động hóa việc triển khai, đảm bảo tính sẵn sàng cao và cho phép mở rộng ứng dụng một cách linh hoạt và hiệu quả. Việc làm chủ nó sẽ mang lại lợi thế cạnh tranh lớn cho cả nhà phát triển cá nhân và doanh nghiệp.

Thế giới công nghệ luôn vận động không ngừng, và việc nắm bắt các công cụ tiên tiến như Kubernetes là chìa khóa để không bị tụt lại phía sau. Đừng ngần ngại, hãy bắt đầu học và thử nghiệm Kubernetes ngay hôm nay để nâng cao hiệu suất phát triển và mở ra những khả năng mới cho các dự án của bạn. Bắt đầu với một cluster local, triển khai ứng dụng “Hello World”, và dần dần khám phá các tính năng nâng cao hơn.

Khi bạn đã quen thuộc với những điều cơ bản, hành trình của bạn với Kubernetes vẫn còn nhiều điều thú vị phía trước. AZWEB khuyến khích bạn tìm hiểu sâu hơn về các công cụ trong hệ sinh thái của nó như Helm (trình quản lý gói cho Kubernetes), thiết lập các đường ống CI/CD tự động với Jenkins hoặc GitLab CI, và khám phá các công cụ giám sát như Prometheus và Grafana. Việc liên tục học hỏi sẽ giúp bạn trở thành một chuyên gia thực thụ trong lĩnh vực điện toán đám mây và container.