Bạn đã bao giờ kiểm tra Google Search Console và bất ngờ thấy thông báo lỗi “Couldn’t fetch” (Không thể tìm nạp)? Đây là một trong những cảnh báo phổ biến nhưng lại có thể gây ra nhiều lo lắng. Lỗi “couldn’t fetch” thường gây khó khăn cho quá trình lập chỉ mục và ảnh hưởng trực tiếp đến hiệu suất SEO của website. Nếu Google không thể “tìm nạp” hay truy cập vào trang của bạn, điều đó có nghĩa là trang đó sẽ không xuất hiện trên kết quả tìm kiếm. Vấn đề này xảy ra khi Googlebot, trình thu thập dữ liệu của Google, cố gắng truy cập một URL trên trang web của bạn nhưng không thành công. Nguyên nhân có thể đến từ nhiều yếu tố khác nhau, từ cấu hình sai lệch đơn giản đến các sự cố phức tạp hơn về máy chủ.

Nhưng đừng quá lo lắng! Đây là một lỗi hoàn toàn có thể khắc phục được. Bài viết này sẽ là kim chỉ nam, hướng dẫn bạn một cách chi tiết và dễ hiểu nhất để kiểm tra, xác định chính xác nguyên nhân và sửa lỗi “couldn’t fetch” một cách hiệu quả. Chúng ta sẽ cùng nhau đi sâu vào từng khía cạnh, từ việc kiểm tra tệp robots.txt, phân tích lỗi máy chủ, cho đến các bước cụ thể để yêu cầu Google lập chỉ mục lại. Hãy cùng AZWEB khám phá cách đưa website của bạn trở lại đúng quỹ đạo và tối ưu hóa cho công cụ tìm kiếm.

Nguyên nhân phổ biến gây ra lỗi couldn’t fetch

Để khắc phục triệt để lỗi “couldn’t fetch”, trước tiên chúng ta cần hiểu rõ những “thủ phạm” đứng sau nó. Việc xác định đúng nguyên nhân sẽ giúp bạn tiết kiệm thời gian và áp dụng giải pháp chính xác nhất. Về cơ bản, lỗi này xuất hiện khi có một rào cản nào đó ngăn Googlebot tiếp cận nội dung trang web của bạn. Có hai nhóm nguyên nhân chính thường gặp nhất.

Lỗi cấu hình robots.txt hoặc thẻ meta noindex

Đây là nhóm nguyên nhân liên quan đến việc bạn vô tình “chặn cửa” Googlebot. Mặc dù các công cụ này rất hữu ích trong việc kiểm soát cách Google thu thập dữ liệu, nhưng chỉ một sai sót nhỏ trong cấu hình cũng có thể gây ra lỗi không mong muốn.

Tệp robots.txt được ví như một tấm biển chỉ dẫn cho các bot công cụ tìm kiếm. Bạn có thể dùng nó để yêu cầu bot không truy cập vào một số thư mục hoặc trang nhất định. Tuy nhiên, nếu bạn cấu hình sai, chẳng hạn như vô tình thêm một dòng lệnh Disallow: / hoặc chặn một thư mục quan trọng, Googlebot sẽ tuân thủ và không thể tìm nạp các URL đó, dẫn đến lỗi “couldn’t fetch”.

Tương tự, thẻ meta robots noindex là một đoạn mã được đặt trong phần <head> của trang HTML. Nó ra lệnh cho công cụ tìm kiếm không lập chỉ mục trang đó. Đôi khi, thẻ này được thêm vào trong quá trình phát triển web để ngăn các trang chưa hoàn thiện xuất hiện trên Google và quên không gỡ bỏ khi website chính thức hoạt động. Việc đặt sai thẻ này trên các trang quan trọng cũng là một nguyên nhân phổ biến gây ra lỗi tìm nạp.

Server hoặc hosting không ổn định

Nhóm nguyên nhân thứ hai đến từ chính nền tảng hạ tầng của website: máy chủ (server) hoặc dịch vụ hosting. Nếu website của bạn được ví như một ngôi nhà, thì hosting chính là mảnh đất và nền móng. Một nền móng không vững chắc chắc chắn sẽ ảnh hưởng đến khả năng tiếp cận của “vị khách” Googlebot.

Khi Googlebot cố gắng truy cập một URL, máy chủ của bạn cần phải phản hồi lại. Nếu máy chủ gặp sự cố và trả về các mã lỗi 5xx (lỗi phía máy chủ) hoặc 4xx (lỗi phía máy khách, ví dụ như 404 Not Found), Googlebot sẽ không thể lấy được dữ liệu. Lỗi 503 (Service Unavailable) là một ví dụ điển hình khi máy chủ quá tải hoặc đang trong quá trình bảo trì.

Ngoài ra, tốc độ phản hồi của máy chủ cũng là một yếu tố quan trọng. Googlebot chỉ có một khoảng thời gian giới hạn để thu thập dữ liệu từ mỗi trang. Nếu máy chủ của bạn phản hồi quá chậm hoặc kết nối bị ngắt quãng (timeout), Googlebot sẽ từ bỏ và báo lỗi “couldn’t fetch”. Tình trạng này thường xảy ra với các gói hosting chất lượng thấp, không đủ tài nguyên để xử lý các yêu cầu truy cập, đặc biệt là khi có lưu lượng truy cập tăng đột biến.

Hướng dẫn kiểm tra trạng thái trang và cấu hình robots.txt

Khi đã nắm được các nguyên nhân tiềm tàng, bước tiếp theo là bắt tay vào kiểm tra thực tế. Việc chẩn đoán đúng bệnh sẽ giúp bạn đưa ra phương thuốc điều trị hiệu quả. Chúng ta sẽ bắt đầu với những yếu tố dễ kiểm tra nhất: tệp robots.txt và các thẻ meta trên trang.

Cách kiểm tra robots.txt bằng Google Search Console và công cụ trực tuyến

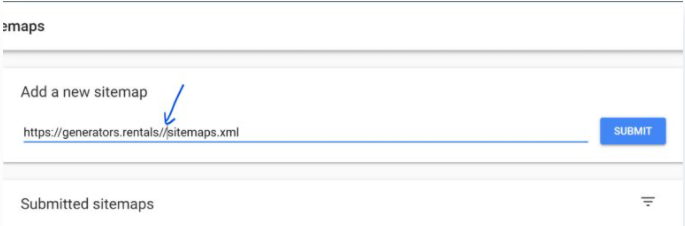

Tệp robots.txt là điểm khởi đầu lý tưởng để điều tra. Google cung cấp một công cụ rất hữu ích ngay trong Search Console để giúp bạn thực hiện việc này một cách dễ dàng.

Để sử dụng, bạn hãy truy cập Google Search Console, vào phần “Cài đặt” (Settings) và tìm đến mục “Thu thập dữ liệu” (Crawling), sau đó mở “Công cụ kiểm tra tệp robots.txt”. Tại đây, bạn có thể xem nội dung tệp robots.txt hiện tại của mình. Công cụ sẽ cho phép bạn nhập một URL cụ thể đang báo lỗi để kiểm tra xem nó có đang bị chặn bởi quy tắc nào không. Nếu URL bị chặn, công cụ sẽ bôi đỏ dòng lệnh gây ra vấn đề và cho bạn biết chính xác quy tắc nào đang ngăn cản Googlebot.

Hãy chú ý đến các dòng lệnh như Disallow. Một dòng Disallow: / sẽ chặn toàn bộ website, trong khi Disallow: /ten-thu-muc/ sẽ chặn một thư mục cụ thể. Hãy đảm bảo rằng không có URL quan trọng nào của bạn bị liệt kê trong các quy tắc này một cách vô ý. Ngoài công cụ của Google, bạn cũng có thể sử dụng các công cụ trực tuyến khác để phân tích tệp robots.txt của mình.

Kiểm tra thẻ meta và header HTTP

Nếu tệp robots.txt của bạn hoàn toàn bình thường, “nghi phạm” tiếp theo chính là thẻ meta robots hoặc thông tin trong header HTTP. Đây là những chỉ thị ở cấp độ trang, ra lệnh cho Googlebot phải làm gì với một URL cụ thể.

Để kiểm tra thẻ meta, bạn hãy truy cập vào URL đang bị lỗi trên trình duyệt. Nhấp chuột phải và chọn “Xem nguồn trang” (View Page Source). Sử dụng chức năng tìm kiếm (Ctrl + F hoặc Cmd + F) và gõ “noindex”. Nếu bạn tìm thấy một đoạn mã như <meta name="robots" content="noindex"> hoặc <meta name="googlebot" content="noindex">, thì đây chính là nguyên nhân. Thẻ này đang yêu cầu Google không lập chỉ mục trang, và do đó gây ra lỗi tìm nạp trong một số trường hợp.

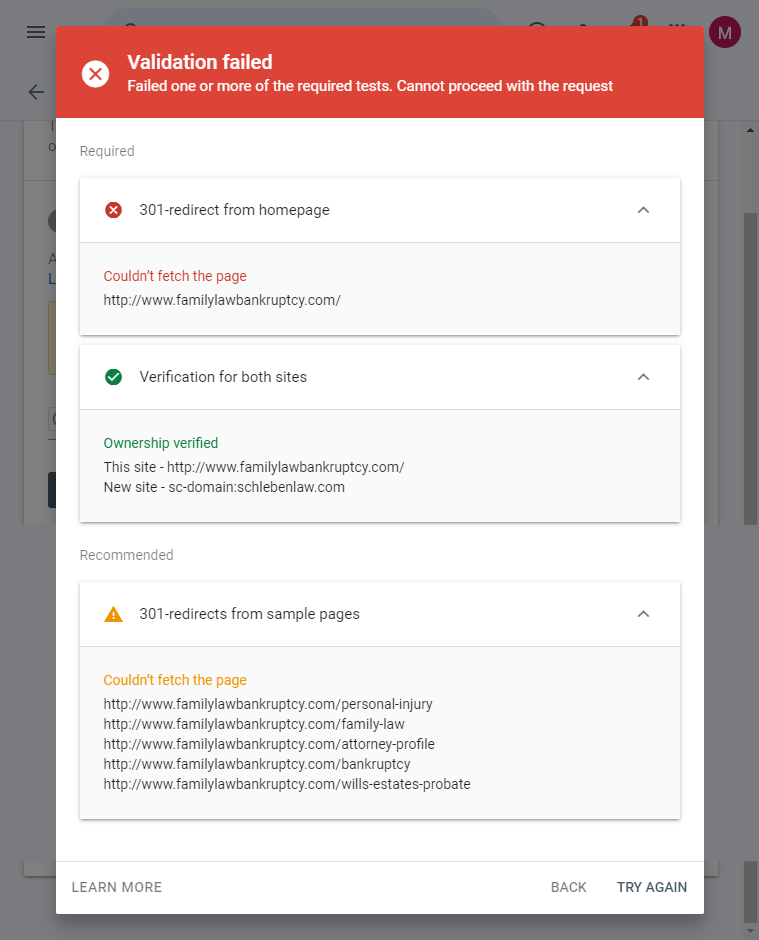

Bên cạnh đó, bạn cũng cần kiểm tra header HTTP. Công cụ “Kiểm tra URL” (URL Inspection) trong Google Search Console là trợ thủ đắc lực nhất cho việc này. Hãy nhập URL bị lỗi vào thanh tìm kiếm trên cùng. Công cụ sẽ cung cấp một báo cáo chi tiết, bao gồm cả việc Google có được phép thu thập dữ liệu hay không và mã trạng thái HTTP mà máy chủ trả về. Hãy đảm bảo rằng trang trả về mã 200 OK, có nghĩa là mọi thứ đều ổn. Nếu nó trả về mã 4xx hoặc 5xx, vấn đề nằm ở phía máy chủ.

Kiểm tra và đảm bảo server hoạt động ổn định

Sau khi đã loại trừ các nguyên nhân từ robots.txt và thẻ meta, đã đến lúc chúng ta hướng sự chú ý đến nền tảng của website: máy chủ và hosting. Một máy chủ không ổn định, chậm chạp hoặc thường xuyên gặp sự cố là một trong những nguyên nhân gốc rễ và nghiêm trọng nhất gây ra lỗi “couldn’t fetch”. Googlebot cần một môi trường truy cập nhanh chóng và đáng tin cậy để làm việc hiệu quả.

Kiểm tra tốc độ phản hồi server và thời gian downtime

Tốc độ không chỉ quan trọng đối với trải nghiệm người dùng mà còn cả với các bot tìm kiếm. Thời gian phản hồi của máy chủ (Server Response Time) là khoảng thời gian máy chủ cần để trả về byte đầu tiên của nội dung sau khi nhận được yêu cầu. Nếu thời gian này quá lâu, Googlebot có thể hết kiên nhẫn và rời đi.

Bạn có thể sử dụng các công cụ trực tuyến miễn phí và trả phí như GTmetrix, Pingdom, hoặc PageSpeed Insights của Google để kiểm tra chỉ số này. Các công cụ này sẽ phân tích URL của bạn và cung cấp một báo cáo chi tiết về hiệu suất, bao gồm cả thời gian phản hồi của máy chủ. Một thời gian phản hồi tốt thường dưới 200ms. Nếu con số này lên đến vài giây, đó là một dấu hiệu đáng báo động.

Bên cạnh đó, thời gian máy chủ không hoạt động (downtime) cũng là một yếu tố chí mạng. Nếu Googlebot truy cập website của bạn đúng vào lúc máy chủ đang bị sập, nó chắc chắn sẽ nhận được lỗi. Bạn có thể sử dụng các dịch vụ theo dõi uptime để giám sát website của mình 24/7 và nhận cảnh báo ngay khi có sự cố xảy ra.

Liên hệ nhà cung cấp hosting hoặc kỹ thuật để xử lý sự cố

Nếu bạn phát hiện ra rằng máy chủ của mình thường xuyên chậm hoặc bị downtime, việc tự khắc phục có thể khá phức tạp nếu bạn không có chuyên môn kỹ thuật. Đây là lúc bạn cần liên hệ với những người có chuyên môn.

Hãy liên hệ ngay với đội ngũ hỗ trợ kỹ thuật của nhà cung cấp hosting của bạn. Cung cấp cho họ các dữ liệu bạn đã thu thập được (ví dụ: báo cáo từ GTmetrix, thời gian xảy ra lỗi). Họ có trách nhiệm kiểm tra tình trạng máy chủ và xác định nguyên nhân, có thể là do tài nguyên không đủ, cấu hình sai, hoặc các vấn đề phần cứng.

Trong nhiều trường hợp, giải pháp có thể là nâng cấp gói hosting của bạn lên một gói cao cấp hơn với nhiều tài nguyên hơn (CPU, RAM). Nếu bạn đang sử dụng shared hosting giá rẻ, việc chuyển sang một giải pháp mạnh mẽ hơn như VPS hoặc hosting chuyên dụng có thể giải quyết dứt điểm vấn đề. Đây là một khoản đầu tư xứng đáng cho sự ổn định và hiệu suất SEO lâu dài của website. Tại AZWEB, chúng tôi cung cấp các giải pháp Hosting và VPS chất lượng cao, được tối ưu hóa để đảm bảo tốc độ và sự ổn định, giúp bạn tránh xa các lỗi liên quan đến máy chủ.

Các bước cụ thể để sửa lỗi couldn’t fetch

Sau khi đã hoàn thành các bước chẩn đoán và xác định được nguyên nhân gốc rễ, giờ là lúc chúng ta hành động. Dưới đây là các bước cụ thể, rõ ràng để bạn có thể tự tin khắc phục lỗi “couldn’t fetch” và mở đường cho Googlebot quay trở lại.

Cập nhật robots.txt và thẻ meta để cho phép Googlebot truy cập

Nếu vấn đề nằm ở các quy tắc chặn, việc sửa chữa khá đơn giản.

Đầu tiên, hãy mở tệp robots.txt của bạn. Tệp này thường nằm ở thư mục gốc của website (ví dụ: yourdomain.com/robots.txt). Tìm đến các dòng Disallow đang chặn các URL hoặc thư mục quan trọng mà bạn muốn Google lập chỉ mục. Hãy xóa các dòng đó đi hoặc sửa chúng lại cho chính xác. Ví dụ, nếu bạn thấy Disallow: /blog/, nhưng lại muốn Google index các bài viết trong blog, bạn cần xóa dòng này. Sau khi chỉnh sửa, hãy lưu tệp lại và sử dụng công cụ kiểm tra của Google Search Console một lần nữa để chắc chắn rằng cấu hình đã đúng.

Tiếp theo, đối với các trang bị gắn thẻ meta noindex một cách không mong muốn, bạn cần truy cập vào mã nguồn của trang đó. Tìm và loại bỏ hoàn toàn dòng <meta name="robots" content="noindex">. Nếu bạn đang sử dụng một CMS như WordPress với các plugin SEO (ví dụ: Yoast SEO, Rank Math), hãy kiểm tra phần cài đặt nâng cao của từng trang hoặc bài viết để đảm bảo tùy chọn “Cho phép công cụ tìm kiếm lập chỉ mục” đã được bật.

Tối ưu server và tăng tốc độ tải trang

Nếu nguyên nhân đến từ máy chủ, bạn cần tập trung vào việc cải thiện hiệu suất và độ ổn định.

Nếu máy chủ thường xuyên trả về mã lỗi 5xx, hãy làm việc với nhà cung cấp hosting của bạn để xác định và khắc phục sự cố. Điều này có thể liên quan đến việc tăng giới hạn tài nguyên (PHP memory limit, execution time), sửa lỗi trong mã nguồn hoặc tối ưu hóa cơ sở dữ liệu.

Để tăng tốc độ tải trang, hãy xem xét các biện pháp sau:

- Kích hoạt bộ nhớ đệm (Caching): Sử dụng các plugin caching hoặc cấu hình caching ở cấp độ máy chủ để giảm thời gian phản hồi.

- Nén hình ảnh: Tối ưu hóa kích thước tất cả các hình ảnh trên trang web của bạn mà không làm giảm chất lượng quá nhiều.

- Sử dụng Mạng phân phối nội dung (CDN): Một CDN sẽ lưu trữ các bản sao của trang web bạn trên nhiều máy chủ toàn cầu, giúp người dùng và cả Googlebot truy cập nhanh hơn từ vị trí gần nhất.

- Nâng cấp gói hosting: Như đã đề cập, nếu hạ tầng hiện tại không đủ đáp ứng, đừng ngần ngại đầu tư vào một giải pháp hosting mạnh mẽ hơn.

Yêu cầu Google lập chỉ mục lại sau khi sửa lỗi

Sau khi bạn đã thực hiện tất cả các thay đổi cần thiết, bước cuối cùng là thông báo cho Google biết rằng vấn đề đã được giải quyết và trang web của bạn đã sẵn sàng để được thu thập dữ liệu trở lại.

Hãy quay trở lại công cụ “Kiểm tra URL” (URL Inspection) trong Google Search Console. Nhập URL đã được sửa lỗi vào ô tìm kiếm. Sau khi công cụ kiểm tra và xác nhận trang có thể truy cập được, bạn sẽ thấy một nút có tên “Yêu cầu lập chỉ mục” (Request Indexing). Hãy nhấp vào đó. Hành động này sẽ gửi URL của bạn vào hàng đợi ưu tiên của Google để được thu thập dữ liệu lại.

Quá trình này có thể mất từ vài giờ đến vài ngày. Hãy kiên nhẫn và theo dõi báo cáo “Trang” (Pages) trong Google Search Console để xem lỗi “couldn’t fetch” có giảm dần và biến mất hay không.

Mẹo và lưu ý để tránh lỗi trong tương lai

Khắc phục lỗi là một việc tốt, nhưng ngăn chặn nó xảy ra ngay từ đầu còn tốt hơn. Việc chủ động duy trì một website “khỏe mạnh” sẽ giúp bạn tiết kiệm thời gian, công sức và đảm bảo hiệu suất SEO luôn ở mức tối ưu. Dưới đây là những mẹo và thói quen tốt bạn nên áp dụng để tránh gặp lại lỗi “couldn’t fetch” trong tương lai.

Kiểm tra robots.txt định kỳ và cập nhật chính xác

Tệp robots.txt không phải là thứ bạn chỉ cài đặt một lần rồi quên. Mỗi khi có sự thay đổi lớn về cấu trúc website, thêm thư mục mới, hoặc thay đổi chính sách thu thập dữ liệu, bạn nên kiểm tra lại tệp này.

Hãy tạo một thói quen kiểm tra tệp robots.txt hàng tháng hoặc hàng quý. Đảm bảo rằng các quy tắc vẫn còn phù hợp với mục tiêu SEO hiện tại của bạn. Thiết lập một chính sách truy cập rõ ràng, chỉ chặn những gì thực sự cần thiết như trang quản trị, các tệp tạm, hoặc các trang kết quả tìm kiếm nội bộ. Luôn sử dụng công cụ kiểm tra của Google Search Console sau mỗi lần cập nhật để đảm bảo không có sai sót nào xảy ra.

Giữ server ổn định, tối ưu bảo trì thường xuyên

Sự ổn định của máy chủ là xương sống của một website. Đừng xem nhẹ việc lựa chọn nhà cung cấp hosting. Hãy chọn một đối tác uy tín, có đội ngũ hỗ trợ kỹ thuật tốt và cam kết về thời gian hoạt động (uptime) cao, lý tưởng là trên 99.9%.

Thực hiện bảo trì website định kỳ. Điều này bao gồm việc cập nhật CMS, theme, và các plugin lên phiên bản mới nhất để vá các lỗ hổng bảo mật và cải thiện hiệu suất. Thường xuyên dọn dẹp cơ sở dữ liệu, xóa các dữ liệu không cần thiết để giữ cho website hoạt động nhẹ nhàng. Nếu bạn đang sử dụng VPS hoặc máy chủ riêng, hãy đảm bảo rằng nó được cấu hình và tối ưu hóa đúng cách. Việc đầu tư vào một dịch vụ hosting chất lượng như của AZWEB sẽ mang lại sự yên tâm và nền tảng vững chắc cho sự phát triển của website.

Theo dõi Reports và Alerts của Google Search Console thường xuyên

Google Search Console là người bạn đồng hành không thể thiếu của mọi quản trị viên web. Công cụ này không chỉ giúp bạn chẩn đoán lỗi khi chúng đã xảy ra, mà còn cung cấp những cảnh báo sớm để bạn hành động kịp thời.

Hãy tạo thói quen đăng nhập vào Google Search Console ít nhất một lần mỗi tuần. Kiểm tra báo cáo “Trang” (Pages) để xem có vấn đề lập chỉ mục nào mới phát sinh hay không. Hãy chắc chắn rằng bạn đã bật thông báo qua email từ Google Search Console. Google sẽ chủ động gửi email cho bạn khi phát hiện ra các vấn đề nghiêm trọng, bao gồm cả sự gia tăng đột ngột của các lỗi máy chủ hoặc lỗi tìm nạp. Việc phát hiện và xử lý sớm các vấn đề này sẽ giúp giảm thiểu tối đa tác động tiêu cực đến thứ hạng SEO của bạn.

Tổng kết và lợi ích khi khắc phục lỗi cho SEO và lập chỉ mục

Hành trình tìm hiểu và khắc phục lỗi “couldn’t fetch” không chỉ đơn thuần là sửa một lỗi kỹ thuật. Đây là một bước quan trọng trong việc đảm bảo sức khỏe tổng thể và tối ưu hóa hiệu suất cho website của bạn trên công cụ tìm kiếm. Việc giải quyết triệt để lỗi này mang lại những lợi ích vô cùng to lớn và trực tiếp.

Những điểm chính chúng ta đã cùng nhau đi qua bao gồm việc xác định các nguyên nhân phổ biến từ robots.txt, thẻ meta noindex cho đến sự bất ổn của máy chủ. Chúng ta cũng đã học cách sử dụng các công cụ trong Google Search Console để chẩn đoán chính xác và thực hiện các bước khắc phục cụ thể. Quan trọng hơn, việc thiết lập các thói quen tốt như kiểm tra định kỳ và theo dõi liên tục sẽ giúp bạn chủ động ngăn chặn các vấn đề tương tự trong tương lai.

Khi bạn khắc phục thành công lỗi “couldn’t fetch”, bạn đang mở rộng cánh cửa để Googlebot có thể truy cập, thu thập dữ liệu và hiểu nội dung của bạn một cách hiệu quả nhất. Điều này trực tiếp làm tăng khả năng các trang quan trọng được lập chỉ mục nhanh chóng và chính xác. Một website dễ dàng truy cập và có nền tảng kỹ thuật vững chắc sẽ được Google đánh giá cao hơn, từ đó cải thiện thứ hạng tìm kiếm và thu hút nhiều lưu lượng truy cập tự nhiên hơn.

Đừng để một lỗi kỹ thuật cản trở sự phát triển của bạn. Hãy kiểm tra ngay tài khoản Google Search Console của mình ngay hôm nay. Áp dụng những hướng dẫn chi tiết từ AZWEB để tìm và sửa lỗi, bảo vệ thành quả SEO và đảm bảo website của bạn luôn trong trạng thái tốt nhất. Hãy nhớ rằng, một nền tảng website vững chắc là bước đệm không thể thiếu cho mọi chiến lược marketing thành công. Tiếp tục theo dõi, tối ưu và áp dụng các kỹ thuật SEO Onpage là gì chuẩn để duy trì hiệu quả bền vững và lâu dài.