Bạn đã bao giờ thắc mắc tại sao một trang web quen thuộc lại tải nhanh hơn trong lần truy cập thứ hai, hoặc tại sao ứng dụng trên điện thoại lại phản hồi tức thì sau vài lần sử dụng? Bí mật đằng sau sự tăng tốc kỳ diệu này chính là bộ nhớ đệm, hay còn gọi là cache là gì. Đây là một thành phần công nghệ thầm lặng nhưng có vai trò cực kỳ quan trọng trong hầu hết các hệ thống máy tính và mạng hiện đại. Tuy nhiên, không phải lúc nào cache cũng hoạt động hoàn hảo. Việc không hiểu rõ về “cache hit” và “cache miss” có thể dẫn đến hiệu suất hệ thống suy giảm, gây ra trải nghiệm chậm chạp cho người dùng. Bài viết này sẽ cùng bạn khám phá chi tiết về cache hit và cache miss, từ khái niệm cơ bản, quy trình hoạt động, đến cách tối ưu hóa để khai thác tối đa sức mạnh của bộ nhớ đệm.

Khái niệm về bộ nhớ đệm (Cache) trong hệ thống máy tính và mạng

Để hiểu được sức mạnh của cache, trước tiên chúng ta cần làm quen với những khái niệm nền tảng. Bộ nhớ đệm không phải là một khái niệm xa vời, nó hiện diện trong mọi thiết bị từ máy tính cá nhân, máy chủ cho đến điện thoại thông minh của bạn.

Bộ nhớ đệm là gì?

Bộ nhớ đệm (cache) là một lớp lưu trữ dữ liệu tốc độ cao, có dung lượng nhỏ, được đặt giữa bộ xử lý trung tâm (CPU) và bộ nhớ chính (RAM) hoặc giữa máy khách và máy chủ. Chức năng chính của nó là lưu trữ tạm thời các dữ liệu hoặc chỉ dẫn được truy cập thường xuyên. Hãy tưởng tượng cache giống như một chiếc bàn làm việc nhỏ ngay cạnh bạn. Thay vì mỗi lần cần một tài liệu lại phải chạy xuống kho lưu trữ khổng lồ (bộ nhớ chính), bạn sẽ giữ những tài liệu quan trọng và hay dùng nhất ngay trên bàn. Điều này giúp bạn lấy chúng nhanh hơn rất nhiều.

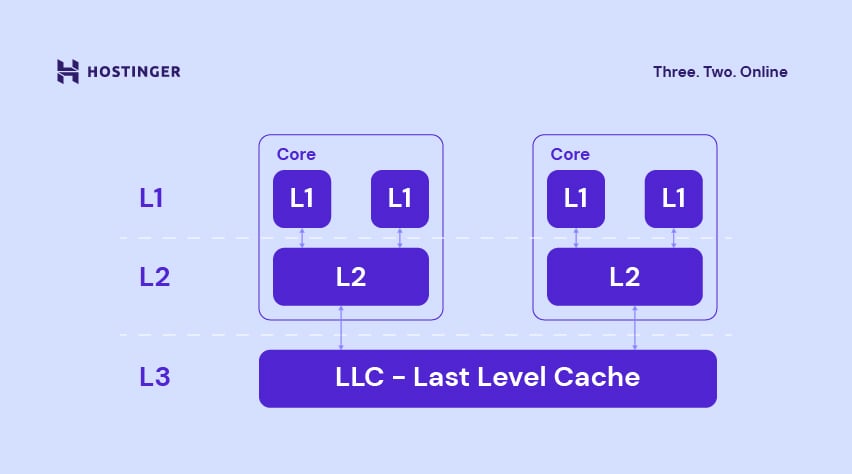

Trong hệ thống máy tính, cache giúp CPU không phải chờ đợi dữ liệu từ RAM, vốn chậm hơn đáng kể. Tương tự, trong mạng máy tính, cache (như CDN – Mạng phân phối nội dung) lưu trữ bản sao của các trang web gần người dùng hơn, giúp giảm thời gian tải trang và tiết kiệm băng thông. Vai trò của cache là tạo ra một “đường tắt” để tăng tốc độ truy xuất dữ liệu, từ đó cải thiện hiệu suất tổng thể của toàn bộ hệ thống.

Cache hit và cache miss là gì?

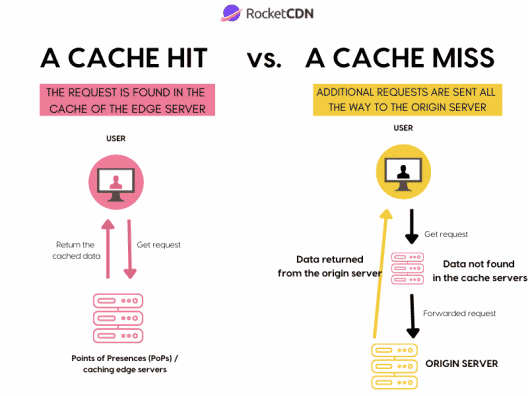

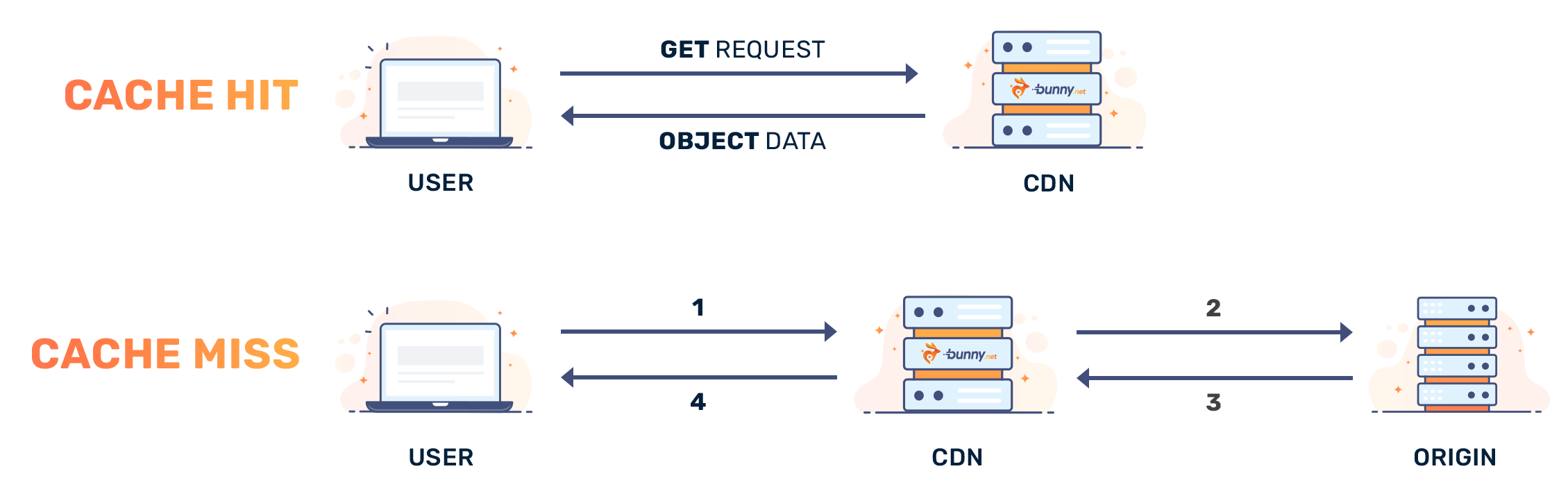

Khi hệ thống cần truy xuất một dữ liệu, nó sẽ tìm kiếm trong cache trước tiên. Tại đây, hai kịch bản có thể xảy ra, và chúng quyết định trực tiếp đến hiệu suất của hệ thống: đó là cache hit và cache miss.

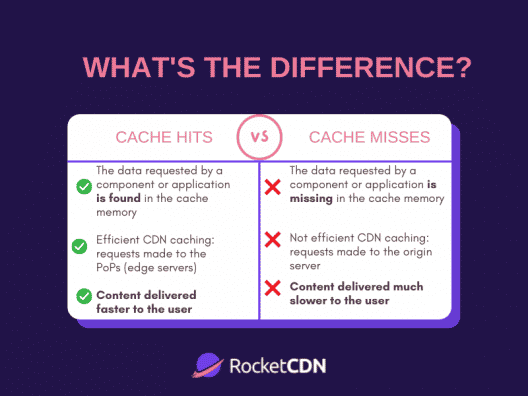

Cache hit (truy cập cache thành công) xảy ra khi dữ liệu mà bộ xử lý cần tìm được tìm thấy ngay trong bộ nhớ đệm. Đây là kịch bản lý tưởng. Khi có cache hit, dữ liệu được trả về ngay lập tức với tốc độ cực nhanh, giúp ứng dụng hoạt động mượt mà và phản hồi tức thì. Tỷ lệ cache hit càng cao, hiệu suất hệ thống càng tốt.

Cache miss (truy cập cache thất bại) xảy ra khi dữ liệu cần tìm không có sẵn trong cache. Lúc này, hệ thống buộc phải thực hiện một quy trình tốn kém hơn: truy cập vào bộ nhớ chính hoặc nguồn dữ liệu gốc (ví dụ: máy chủ web) để lấy dữ liệu. Sau khi lấy được, dữ liệu này thường sẽ được sao chép vào cache để các lần truy cập sau có thể trở thành cache hit. Mỗi lần xảy ra cache miss, hệ thống sẽ bị một khoảng trễ, gọi là “miss penalty”.

Hiểu rõ sự khác biệt và tầm quan trọng của hai khái niệm này là bước đầu tiên để chẩn đoán các vấn đề về hiệu suất và xây dựng các chiến lược tối ưu hóa cache hiệu quả, đảm bảo hệ thống luôn hoạt động ở tốc độ cao nhất.

Quy trình truy xuất dữ liệu qua cache và cách xác định cache hit/cache miss

Để tối ưu hóa cache, việc nắm bắt cách hệ thống tương tác với nó là vô cùng quan trọng. Quy trình này diễn ra chỉ trong vài nano giây nhưng lại là yếu tố quyết định đến tốc độ phản hồi của mọi tác vụ.

Cách thức truy xuất dữ liệu trong hệ thống có cache

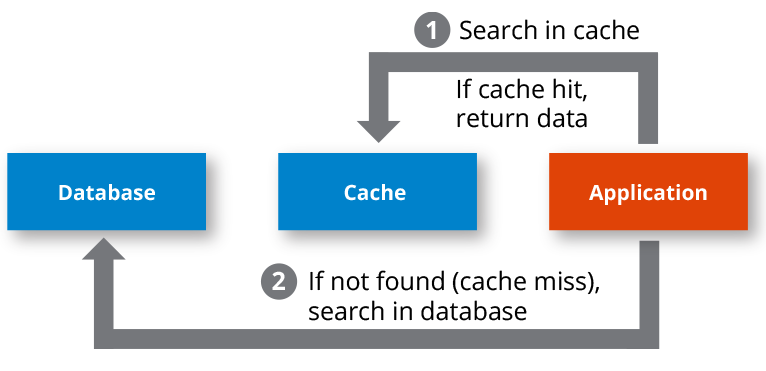

Khi một ứng dụng hoặc CPU cần một phần dữ liệu, nó không đi thẳng đến bộ nhớ chính (RAM). Thay vào đó, nó thực hiện một quy trình thông minh và tuần tự để tiết kiệm thời gian.

Đầu tiên, hệ thống sẽ gửi yêu cầu truy xuất dữ liệu đến bộ điều khiển cache. Bộ điều khiển này sẽ kiểm tra xem dữ liệu có địa chỉ tương ứng đã được lưu trong cache hay chưa. Mỗi mục dữ liệu trong cache đều được gắn với một “thẻ” (tag) chứa thông tin về địa chỉ của nó trong bộ nhớ chính. Hệ thống sẽ so sánh địa chỉ của dữ liệu đang được yêu cầu với các thẻ này.

Nếu một thẻ khớp với địa chỉ yêu cầu, điều đó có nghĩa là dữ liệu đang có sẵn trong cache. Đây chính là một cache hit. Ngược lại, nếu sau khi quét qua tất cả các thẻ mà không tìm thấy sự trùng khớp, hệ thống xác định đây là một cache miss. Lúc này, một quy trình phức tạp hơn sẽ được kích hoạt để lấy dữ liệu từ nguồn chậm hơn.

Toàn bộ quá trình kiểm tra và đối chiếu này được thiết kế để diễn ra cực nhanh, đảm bảo rằng nếu dữ liệu có trong cache, nó sẽ được truy xuất gần như ngay lập tức.

Xác định cache hit và cache miss

Việc xác định một yêu cầu là cache hit hay cache miss là một quá trình logic do phần cứng hoặc phần mềm quản lý cache thực hiện.

Khi một cache hit xảy ra, hệ thống chỉ đơn giản là đọc dữ liệu từ dòng cache tương ứng và gửi nó đến CPU hoặc ứng dụng yêu cầu. Quá trình này kết thúc nhanh chóng, không có độ trễ đáng kể. Đây là con đường nhanh nhất và hiệu quả nhất để truy xuất dữ liệu.

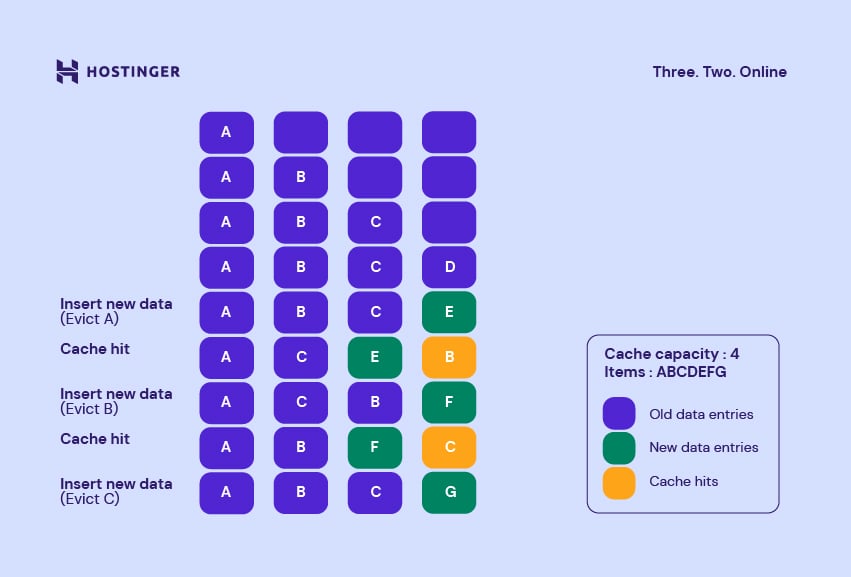

Ngược lại, khi một cache miss xảy ra, phản ứng của hệ thống sẽ phức tạp hơn. Trước hết, yêu cầu truy xuất dữ liệu sẽ được chuyển tiếp đến bộ nhớ chính hoặc máy chủ gốc. Quá trình này mất nhiều thời gian hơn đáng kể. Sau khi dữ liệu được tìm thấy ở nguồn, nó sẽ được gửi đến nơi yêu cầu (CPU) và đồng thời, một bản sao của nó cũng được nạp vào cache. Việc nạp dữ liệu mới vào cache có thể yêu cầu phải loại bỏ một mục dữ liệu cũ nào đó để nhường chỗ, dựa trên các thuật toán thay thế như LRU (Least Recently Used) hay FIFO (First-In, First-Out).

Quy trình xử lý cache miss này tuy gây ra độ trễ ban đầu nhưng lại mang tính chiến lược, vì nó giúp tăng khả năng lần truy cập tiếp theo vào cùng một dữ liệu sẽ trở thành một cache hit.

Ảnh hưởng của cache hit và cache miss đến hiệu suất hệ thống

Tỷ lệ giữa cache hit và cache miss không chỉ là một con số kỹ thuật. Nó có tác động trực tiếp và rõ rệt đến trải nghiệm người dùng cuối, từ tốc độ tải một trang web cho đến độ mượt của một trò chơi điện tử.

Tác động của cache hit đến tốc độ xử lý và độ trễ

Mỗi lần cache hit xảy ra là một chiến thắng cho hiệu suất hệ thống. Lợi ích lớn nhất và rõ ràng nhất là giảm đáng kể thời gian truy xuất dữ liệu. Truy cập dữ liệu từ cache trên CPU (L1, L2, L3) nhanh hơn hàng chục đến hàng trăm lần so với truy cập từ RAM. Tương tự, việc lấy dữ liệu từ cache của trình duyệt hoặc CDN nhanh hơn rất nhiều so với việc gửi yêu cầu qua internet đến máy chủ gốc.

Việc giảm độ trễ này mang lại nhiều lợi ích thực tế. Ví dụ, khi bạn truy cập lại một trang thương mại điện tử, các hình ảnh sản phẩm, logo, và các tệp CSS đã được lưu trong cache của trình duyệt. Trang web sẽ tải gần như ngay lập tức vì trình duyệt không cần phải tải lại những tài nguyên này. Điều này không chỉ cải thiện trải nghiệm người dùng mà còn giảm tải cho máy chủ và tiết kiệm băng thông. Trong các hệ thống cơ sở dữ liệu, cache hit giúp các truy vấn thường xuyên được thực thi nhanh hơn, làm tăng tốc độ phản hồi của toàn bộ ứng dụng.

Tỷ lệ cache hit cao đồng nghĩa với việc CPU luôn “bận rộn” xử lý thay vì “chờ đợi” dữ liệu, giúp khai thác tối đa sức mạnh phần cứng.

Hệ quả từ cache miss và các chi phí phát sinh

Ngược lại với cache hit, mỗi lần cache miss xảy ra đều đi kèm với một “chi phí phạt” (miss penalty). Chi phí này chính là thời gian bị lãng phí để truy xuất dữ liệu từ một nguồn lưu trữ chậm hơn. Khi tỷ lệ cache miss tăng cao, hiệu suất của hệ thống sẽ suy giảm một cách rõ rệt.

Hệ quả đầu tiên là tốc độ xử lý chậm lại. CPU phải tạm dừng các hoạt động tính toán để chờ dữ liệu được lấy về từ RAM. Đối với các ứng dụng web, cache miss tại CDN hoặc tại máy chủ có thể khiến thời gian phản hồi tăng vọt, người dùng phải chờ đợi lâu hơn để trang web hiển thị. Điều này có thể dẫn đến tỷ lệ thoát trang cao và ảnh hưởng tiêu cực đến doanh thu.

Thêm vào đó, cache miss còn gây tốn kém tài nguyên hệ thống. Việc liên tục phải truy cập bộ nhớ chính hoặc gửi yêu cầu qua mạng làm tăng tải cho RAM, CPU và băng thông mạng. Trong môi trường đám mây, việc truyền dữ liệu ra ngoài thường xuyên do cache miss có thể làm phát sinh chi phí không mong muốn. Tóm lại, cache miss không chỉ làm chậm hệ thống mà còn làm tăng chi phí vận hành và lãng phí tài nguyên quý giá.

Các vấn đề thường gặp và cách khắc phục (Common Issues/Troubleshooting)

Ngay cả những hệ thống được thiết kế tốt nhất cũng có thể gặp phải các vấn đề liên quan đến hiệu suất cache. Việc nhận biết nguyên nhân và triệu chứng là bước quan trọng để có thể khắc phục kịp thời.

Cache miss tăng cao do nguyên nhân nào?

Tỷ lệ cache miss cao là một dấu hiệu cảnh báo rằng chiến lược caching của bạn không hiệu quả. Có nhiều nguyên nhân phổ biến dẫn đến tình trạng này:

- Dung lượng cache quá nhỏ: Đây là nguyên nhân rõ ràng nhất. Nếu cache không đủ lớn để chứa tập dữ liệu làm việc (working set) của ứng dụng, dữ liệu sẽ liên tục bị đẩy ra và nạp vào, gây ra hiện tượng “trashing” và làm tăng cache miss.

- Thuật toán thay thế cache không phù hợp: Các thuật toán như LRU (Loại bỏ phần tử ít được sử dụng gần đây nhất) hay FIFO (Vào trước ra trước) hoạt động tốt trong nhiều trường hợp, nhưng có thể không tối ưu cho mọi loại ứng dụng. Ví dụ, một thuật toán quét toàn bộ dữ liệu lớn một lần có thể làm “ô nhiễm” cache LRU bằng những dữ liệu chỉ dùng một lần.

- Dữ liệu truy cập không có tính cục bộ (Locality of Reference): Các hệ thống cache hoạt động hiệu quả nhất khi dữ liệu được truy cập có tính cục bộ về không gian (các dữ liệu gần nhau được truy cập cùng lúc) và thời gian (cùng một dữ liệu được truy cập nhiều lần trong khoảng thời gian ngắn). Nếu mã nguồn hoặc truy vấn nhảy lung tung qua các vùng nhớ khác nhau, tỷ lệ cache miss sẽ tăng.

- Cache bị vô hiệu hóa hoặc làm mới quá thường xuyên: Việc làm sạch cache (cache invalidation) quá thường xuyên sẽ khiến hệ thống liên tục phải nạp lại dữ liệu từ đầu, dẫn đến nhiều cache miss bắt buộc (compulsory misses).

Ví dụ thực tế, một trang tin tức có lượng bài viết mới cập nhật liên tục. Nếu cache được thiết lập với thời gian sống (TTL) quá ngắn, nó sẽ bị làm mới liên tục, và người dùng truy cập trang chủ sẽ thường xuyên gặp phải cache miss khi hệ thống phải lấy lại nội dung mới từ cơ sở dữ liệu.

Cache hit thấp ảnh hưởng như thế nào đến hệ thống?

Khi tỷ lệ cache hit thấp, hệ thống sẽ bắt đầu biểu hiện những “triệu chứng” rõ rệt, báo hiệu hiệu suất đang gặp vấn đề.

Triệu chứng đầu tiên và dễ nhận thấy nhất là ứng dụng hoặc trang web chạy chậm. Người dùng sẽ cảm thấy độ trễ tăng lên trong mọi tương tác, từ việc tải trang, thực hiện tìm kiếm cho đến lưu một biểu mẫu. Điều này trực tiếp ảnh hưởng đến sự hài lòng của người dùng.

Một dấu hiệu khác là tải hệ thống tăng cao. Do phải liên tục truy cập vào các nguồn dữ liệu chậm hơn như đĩa cứng hoặc cơ sở dữ liệu, CPU và I/O (Input/Output) của máy chủ sẽ phải làm việc nhiều hơn. Bạn có thể thấy mức sử dụng CPU tăng vọt hoặc thời gian chờ đĩa (disk wait time) kéo dài trong các công cụ giám sát hệ thống.

Ngoài ra, lưu lượng mạng cũng có thể tăng đột biến. Nếu cache ở tầng biên (edge cache) như CDN không hiệu quả, mọi yêu cầu sẽ phải đi về máy chủ gốc, làm tăng gánh nặng cho kết nối mạng và có thể gây ra chi phí băng thông không cần thiết.

Để khắc phục bước đầu, bạn có thể bắt đầu bằng việc kiểm tra các số liệu thống kê cache (nếu có), xem xét lại cấu hình dung lượng cache và chính sách hết hạn. Đôi khi, một sự điều chỉnh nhỏ trong cấu hình cũng có thể mang lại cải thiện lớn về hiệu suất.

Các phương pháp tối ưu tốt nhất (Best Practices)

Quản lý cache hiệu quả là một nghệ thuật cân bằng giữa tốc độ, tính nhất quán của dữ liệu và chi phí tài nguyên. Áp dụng các phương pháp tốt nhất sau đây sẽ giúp bạn tối đa hóa tỷ lệ cache hit và duy trì hiệu suất hệ thống ổn định.

Định kỳ làm sạch và cập nhật cache để tránh dữ liệu lỗi thời: Dữ liệu trong cache có thể trở nên cũ và không còn khớp với nguồn dữ liệu gốc. Việc có một chiến lược vô hiệu hóa cache (cache invalidation) rõ ràng là rất quan trọng. Bạn có thể sử dụng cơ chế dựa trên thời gian sống (Time-To-Live – TTL) để cache tự động hết hạn, hoặc chủ động xóa cache khi dữ liệu gốc thay đổi.

Sử dụng các thuật toán hiệu quả trong quản lý cache: Lựa chọn thuật toán thay thế cache phù hợp với mẫu truy cập của ứng dụng là chìa khóa. LRU (Least Recently Used) là lựa chọn phổ biến và hiệu quả cho nhiều trường hợp. Tuy nhiên, với các mẫu truy cập khác, bạn có thể cân nhắc LFU (Least Frequently Used – loại bỏ mục ít được sử dụng nhất) hoặc các thuật toán phức tạp hơn để tránh tình trạng các dữ liệu quan trọng bị đẩy ra khỏi cache quá sớm.

Tối ưu dung lượng cache phù hợp với đặc tính ứng dụng: Dung lượng cache không phải lúc nào cũng “càng lớn càng tốt”. Một cache quá lớn có thể lãng phí bộ nhớ, trong khi một cache quá nhỏ sẽ gây ra tỷ lệ miss cao. Hãy phân tích “tập dữ liệu làm việc” (working set) của ứng dụng – tức là lượng dữ liệu được truy cập thường xuyên – và cấp phát dung lượng cache vừa đủ để chứa nó.

Tránh lưu trữ quá nhiều dữ liệu không cần thiết trong cache: Chỉ nên cache những dữ liệu thực sự được truy cập thường xuyên và tốn nhiều thời gian để tạo ra. Việc cache những dữ liệu ít khi được sử dụng hoặc dễ dàng tính toán lại sẽ làm loãng cache, chiếm chỗ của những dữ liệu quan trọng hơn.

Linh hoạt điều chỉnh chính sách caching theo nhu- cầu thực tế của hệ thống: Hiệu suất cache không phải là thứ “cài đặt một lần rồi quên”. Hãy thường xuyên theo dõi các chỉ số như tỷ lệ cache hit/miss, độ trễ và tải hệ thống. Dựa trên dữ liệu thu thập được, hãy sẵn sàng điều chỉnh lại dung lượng cache, thời gian TTL, hoặc thậm chí là thuật toán quản lý để thích ứng với sự thay đổi trong hành vi người dùng và đặc tính của ứng dụng.

Kết luận

Qua bài viết, chúng ta đã cùng nhau khám phá vai trò trung tâm của bộ nhớ đệm cũng như tầm quan trọng của hai trạng thái cốt lõi: cache hit và cache miss. Cache hit là “chìa khóa vàng” giúp hệ thống đạt được tốc độ xử lý vượt trội và giảm thiểu độ trễ, mang lại trải nghiệm mượt mà cho người dùng. Ngược lại, cache miss chính là “nút thắt cổ chai” gây ra sự chậm trễ, lãng phí tài nguyên và làm suy giảm hiệu suất tổng thể. Việc hiểu rõ và cân bằng được tỷ lệ giữa hai trạng thái này là yếu tố quyết định đến sự thành công của một hệ thống hiệu năng cao.

Đừng xem việc quản lý cache chỉ là một công việc kỹ thuật đơn thuần. Hãy coi đó là một chiến lược liên tục để cải thiện tốc độ và sự ổn định cho ứng dụng của bạn. Bằng cách áp dụng các kỹ thuật tối ưu đã thảo luận, từ việc lựa chọn dung lượng cache phù hợp, sử dụng thuật toán thông minh cho đến việc xây dựng chính sách làm mới dữ liệu hợp lý, bạn có thể nâng cao đáng kể hiệu suất hệ thống. Bước tiếp theo cho bạn là hãy bắt đầu phân tích hệ thống của mình, xác định các điểm nghẽn và xây dựng một chiến lược quản lý cache được đo lường và tùy chỉnh riêng cho môi trường hoạt động của mình để đạt được hiệu quả tối ưu và bền vững.