Trong thế giới công nghệ hiện đại, khả năng xử lý song song đã trở thành yếu tố then chốt, quyết định hiệu suất của các ứng dụng từ trí tuệ nhân tạo đến đồ họa máy tính. Tuy nhiên, các bộ xử lý trung tâm (CPU) truyền thống, vốn được thiết kế để xử lý các tác vụ tuần tự, đang dần bộc lộ những giới hạn khi phải đối mặt với khối lượng tính toán khổng lồ. Chúng gặp khó khăn trong việc giải quyết các bài toán phức tạp đòi hỏi hàng nghìn phép tính đồng thời. Để giải quyết thách thức này, CUDA là gì, một nền tảng lập trình song song và mô hình lập trình do NVIDIA phát triển, đã ra đời. Công nghệ này mở ra một kỷ nguyên mới, cho phép chúng ta khai thác toàn bộ sức mạnh của bộ xử lý đồ họa (GPU là gì) cho các tác vụ tính toán đa năng. Bài viết này sẽ đi sâu vào cơ chế hoạt động, lợi ích, ứng dụng thực tiễn và so sánh hiệu năng giữa CUDA và CPU, giúp bạn có cái nhìn toàn diện về công nghệ đột phá này.

Giới thiệu tổng quan về CUDA

Ngày nay, công nghệ xử lý song song ngày càng đóng vai trò quan trọng trong các ứng dụng đòi hỏi hiệu năng cao. Từ việc huấn luyện các mô hình machine learning là gì phức tạp đến phân tích dữ liệu lớn và mô phỏng khoa học, nhu cầu xử lý đồng thời hàng triệu phép tính đã trở thành một yêu cầu bắt buộc. Đây là lúc những hạn chế của CPU truyền thống trở nên rõ ràng. CPU, với số lượng lõi xử lý hạn chế, được tối ưu hóa cho các tác vụ tuần tự hoặc song song ở mức độ thấp, dẫn đến tình trạng “thắt cổ chai” khi xử lý các công việc phức tạp.

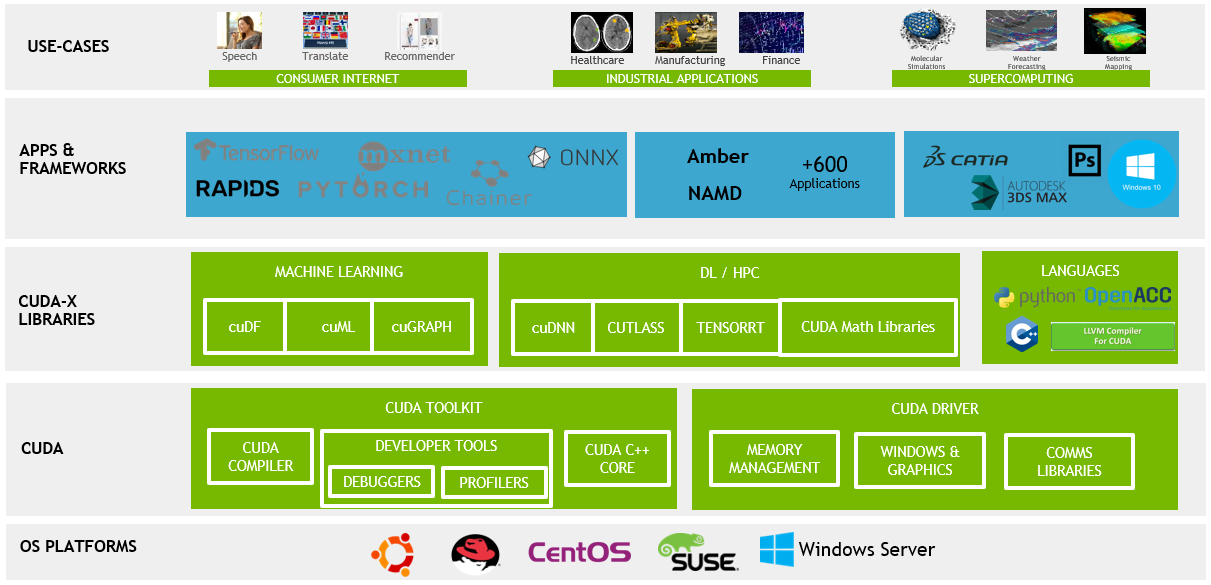

Để vượt qua rào cản này, CUDA (Compute Unified Device Architecture) đã được NVIDIA giới thiệu như một giải pháp toàn diện. Đây không chỉ là một phần cứng, mà là một nền tảng lập trình hoàn chỉnh, cho phép các nhà phát triển sử dụng ngôn ngữ lập trình C/C++ (và các ngôn ngữ khác) để viết các chương trình chạy trên GPU của NVIDIA. Về cơ bản, CUDA mở ra cánh cửa để khai thác hàng nghìn lõi xử lý chuyên dụng bên trong GPU, biến nó thành một “siêu máy tính” mini dành cho các tác vụ song song. Bài viết này sẽ giúp bạn hiểu rõ CUDA là gì, cơ chế hoạt động của nó, những lợi ích vượt trội mà nó mang lại, các ứng dụng tiêu biểu trong AI và đồ họa, cũng như so sánh hiệu năng trực tiếp với CPU.

Cơ chế hoạt động của CUDA trên GPU

Để hiểu được sức mạnh của CUDA, trước hết chúng ta cần tìm hiểu cách nó hoạt động ở cấp độ kiến trúc và mô hình lập trình. CUDA không phải là phép màu, mà là một sự kết hợp thông minh giữa phần cứng GPU và một lớp phần mềm trừu tượng hóa mạnh mẽ.

Kiến trúc và nguyên tắc hoạt động của CUDA

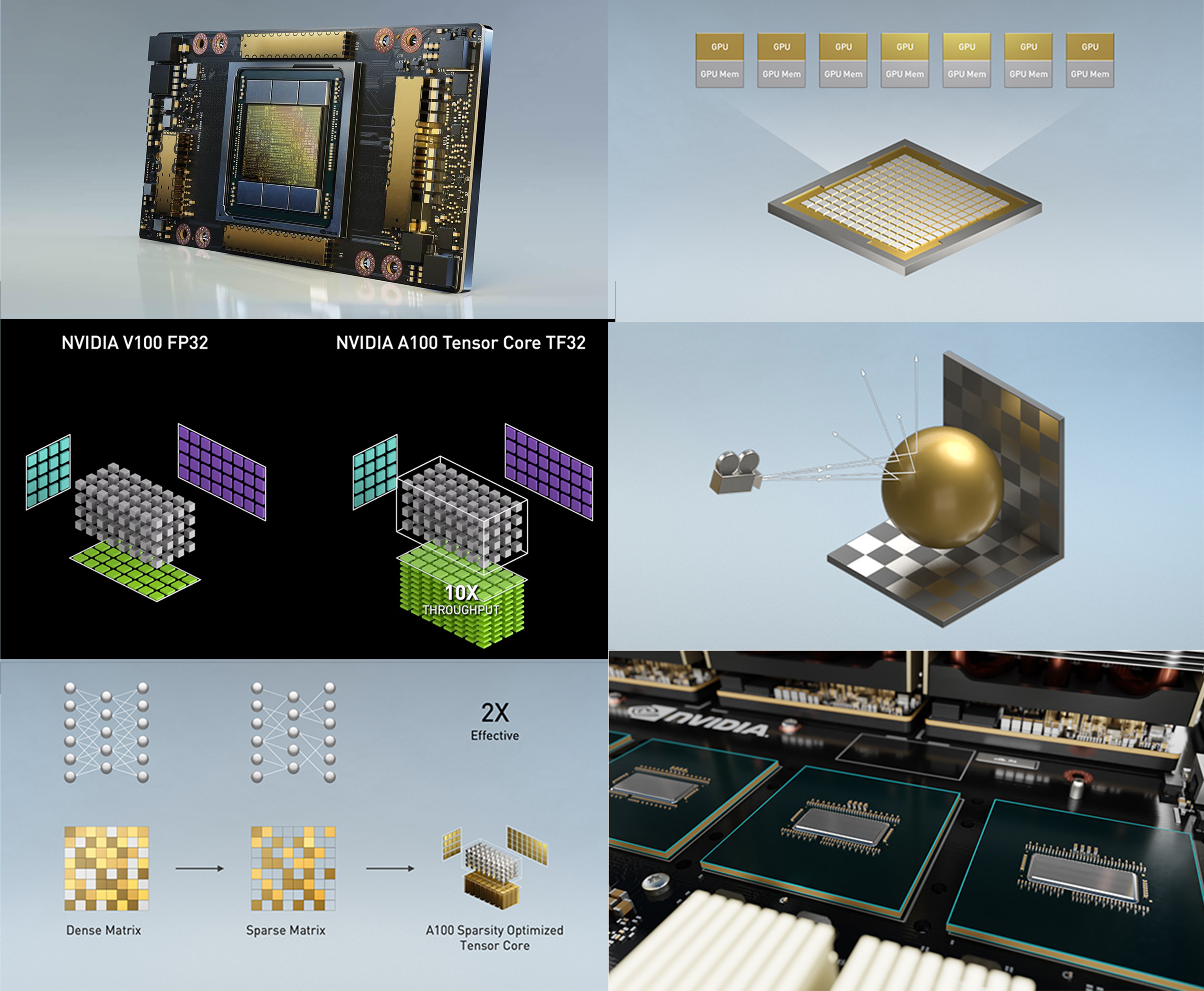

Trái tim của một GPU NVIDIA hiện đại là hàng trăm, thậm chí hàng nghìn lõi xử lý nhỏ gọi là “lõi CUDA” (CUDA cores). Hãy tưởng tượng CPU giống như một vài chuyên gia có khả năng giải quyết các vấn đề phức tạp một cách tuần tự, trong khi GPU giống như một đội quân hàng nghìn công nhân, mỗi người thực hiện một nhiệm vụ đơn giản nhưng tất cả đều làm việc cùng một lúc. Các lõi CUDA này được thiết kế để thực thi cùng một chỉ thị trên nhiều dữ liệu khác nhau, một nguyên tắc gọi là SIMT (Single Instruction, Multiple Threads). Chính khả năng song song hóa tác vụ ở quy mô lớn này là nền tảng tạo nên sức mạnh của CUDA. Thay vì xử lý từng điểm ảnh hay từng phép tính một, GPU có thể xử lý hàng nghìn điểm ảnh hoặc phép tính đồng thời, giúp tăng tốc độ lên gấp nhiều lần.

Lập trình và mô hình CUDA

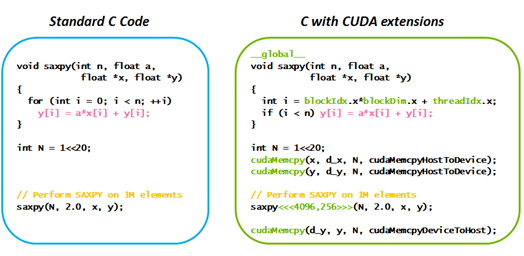

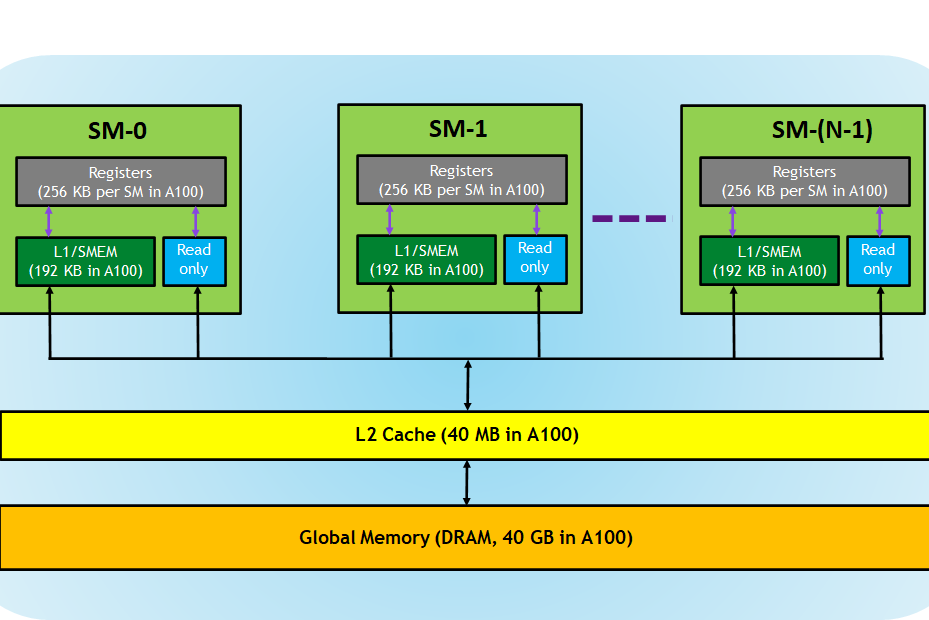

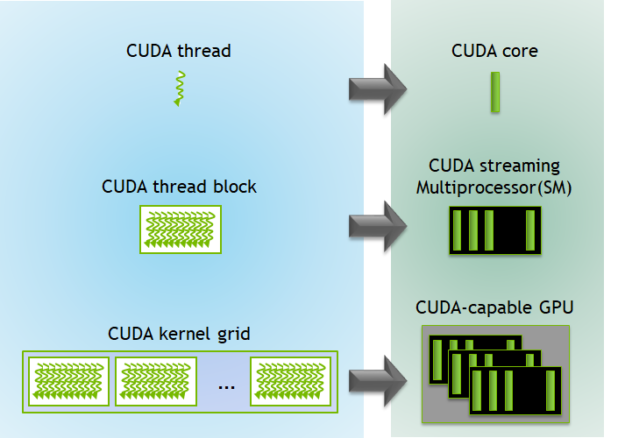

Để lập trình viên có thể khai thác sức mạnh này, CUDA cung cấp một mô hình lập trình rõ ràng. Trong đó, hai khái niệm cốt lõi là Kernel và Thread. Một Kernel là một hàm (function) được viết bằng C/C++ và sẽ được thực thi trên GPU bởi rất nhiều luồng (thread) cùng một lúc. Mỗi thread là một đơn vị thực thi độc lập, có ID riêng và thực hiện cùng một đoạn mã Kernel nhưng trên các phần dữ liệu khác nhau. Các thread này được nhóm lại thành các khối (block), và các khối lại được tổ chức trong một lưới (grid). Mô hình này cho phép lập trình viên dễ dàng quản lý và mở rộng quy mô xử lý cho hàng triệu luồng. Về bộ nhớ, CUDA cung cấp các không gian bộ nhớ khác nhau. Bộ nhớ toàn cầu (global memory) có dung lượng lớn nhưng tốc độ truy cập chậm hơn, giống như một kho lưu trữ trung tâm. Trong khi đó, bộ nhớ chia sẻ (shared memory) có dung lượng nhỏ hơn nhưng tốc độ cực nhanh, hoạt động như một bộ nhớ đệm tốc độ cao cho các thread trong cùng một block, giúp tối ưu hóa hiệu suất tính toán.

Lợi ích và ưu điểm của việc sử dụng CUDA

Việc áp dụng CUDA không chỉ là một lựa chọn công nghệ mà còn là một chiến lược đầu tư thông minh, mang lại những lợi ích đáng kể về hiệu suất, chi phí và khả năng mở rộng cho các dự án đòi hỏi tính toán chuyên sâu.

Tăng tốc xử lý vượt trội so với CPU truyền thống

Ưu điểm lớn nhất và rõ ràng nhất của CUDA là khả năng tăng tốc độ xử lý một cách đáng kinh ngạc. Nhờ kiến trúc song song với hàng nghìn lõi, GPU có thể thực hiện các tác vụ tính toán lặp đi lặp lại nhanh hơn CPU từ hàng chục đến hàng trăm lần. Ví dụ, một tác vụ phân tích dữ liệu hoặc huấn luyện mô hình AI có thể mất vài ngày để hoàn thành trên một hệ thống chỉ dùng CPU, nhưng với sự hỗ trợ của GPU thông qua CUDA, thời gian này có thể được rút ngắn xuống chỉ còn vài giờ. Sự song song hóa tối đa giúp giảm đáng kể thời gian chờ đợi, cho phép các nhà khoa học, kỹ sư và nhà phát triển nhận được kết quả nhanh hơn, từ đó đẩy nhanh chu kỳ nghiên cứu và phát triển sản phẩm.

Tiết kiệm chi phí và tối ưu hiệu năng

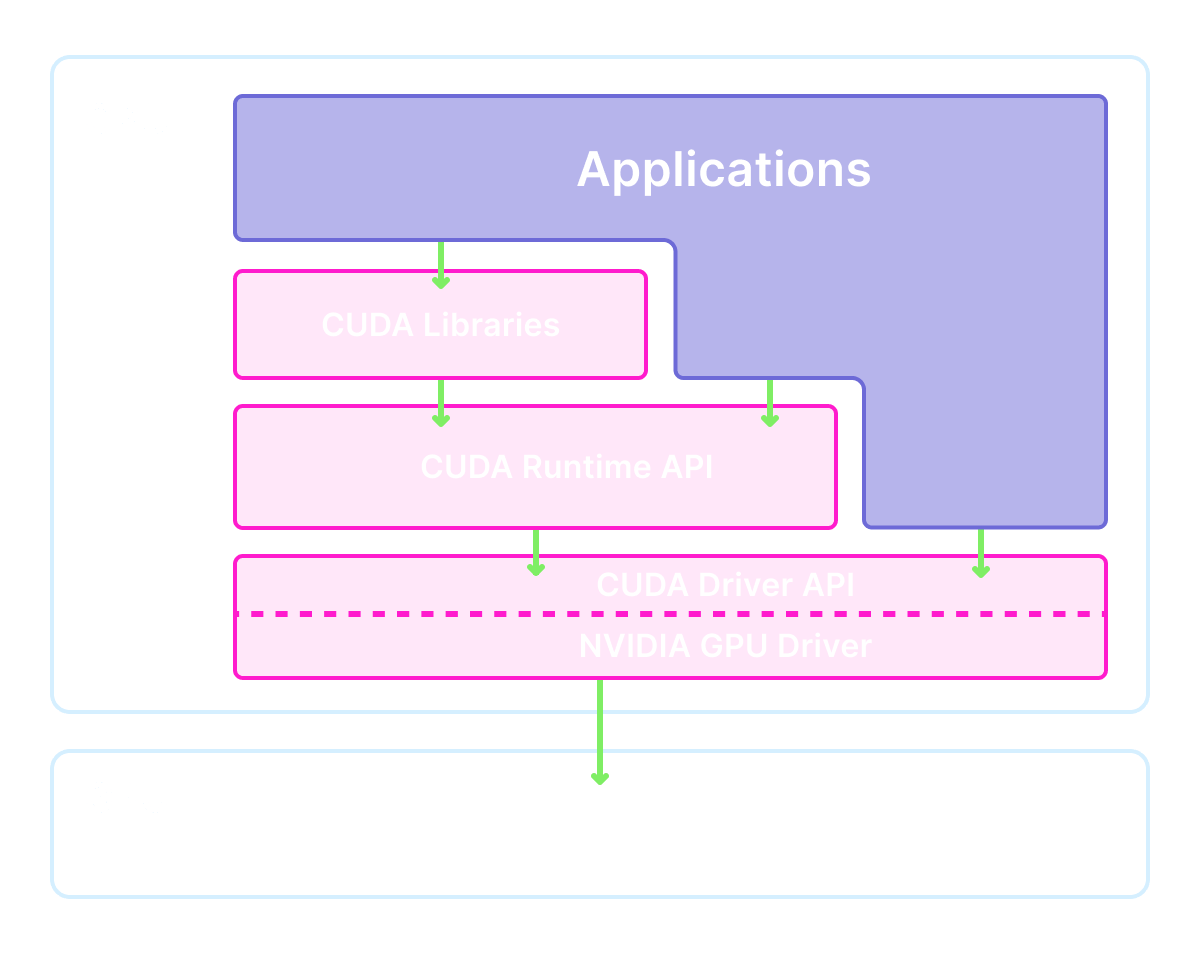

Một lợi ích quan trọng khác là tối ưu hóa chi phí. Thay vì phải đầu tư vào các cụm máy chủ CPU đắt đỏ hoặc các hệ thống phần cứng chuyên dụng, các tổ chức có thể tận dụng sức mạnh của các card đồ họa NVIDIA đã có sẵn trên thị trường. Nhiều máy trạm và máy tính cá nhân hiện nay đã được trang bị GPU có hỗ trợ CUDA, biến chúng thành những cỗ máy tính toán hiệu năng cao với chi phí phải chăng. Hơn nữa, CUDA được hỗ trợ trên nhiều nền tảng hệ điều hành khác nhau như Windows, Linux và macOS. Cùng với đó là một cộng đồng phát triển khổng lồ và hệ sinh thái thư viện phong phú (như cuDNN cho deep learning là gì, cuBLAS cho đại số tuyến tính), giúp lập trình viên dễ dàng tích hợp và tối ưu hóa ứng dụng của mình mà không cần phải xây dựng mọi thứ từ đầu.

Ứng dụng của CUDA trong trí tuệ nhân tạo và xử lý hình ảnh

Sức mạnh xử lý song song của CUDA đã biến nó trở thành công nghệ nền tảng không thể thiếu trong hai lĩnh vực phát triển nhanh nhất hiện nay: trí tuệ nhân tạo (AI) và xử lý hình ảnh. Khả năng xử lý lượng lớn dữ liệu đồng thời đã mở ra những tiềm năng ứng dụng vô hạn.

Vai trò của CUDA trong đào tạo và inference AI

Trong lĩnh vực AI, đặc biệt là học máy (machine learning) và học sâu (deep learning), CUDA đóng vai trò trung tâm. Quá trình huấn luyện (training) một mô hình AI, chẳng hạn như mạng nơ-ron tích chập (CNN) để nhận dạng hình ảnh, đòi hỏi hàng tỷ phép tính nhân ma trận và vector. Các phép tính này có bản chất song song cao, và đây chính là nơi GPU và CUDA tỏa sáng. Việc sử dụng GPU được tăng tốc bởi CUDA giúp giảm thời gian huấn luyện từ vài tuần hoặc vài tháng xuống chỉ còn vài ngày. Các thư viện AI hàng đầu như TensorFlow, PyTorch và Keras đều được xây dựng trên nền tảng CUDA và cuDNN (thư viện deep learning của NVIDIA) để tối ưu hóa hiệu suất. Không chỉ trong giai đoạn huấn luyện, CUDA còn quan trọng trong giai đoạn suy luận (inference), khi mô hình AI đã được huấn luyện được triển khai để đưa ra dự đoán trong thời gian thực, ví dụ như trong các hệ thống nhận diện khuôn mặt hoặc xe tự lái.

Ứng dụng trong xử lý ảnh, video và đồ họa

Khả năng xử lý song song của CUDA cũng là một lợi thế tự nhiên cho các tác vụ xử lý hình ảnh, video và đồ họa máy tính. Trong y tế, CUDA được sử dụng để tăng tốc quá trình tái tạo và phân tích hình ảnh từ máy quét CT và MRI, giúp bác sĩ chẩn đoán bệnh nhanh và chính xác hơn. Trong ngành công nghiệp giải trí, nó được dùng để dựng hình (render là gì) các hiệu ứng hình ảnh (VFX) phức tạp và các mô hình 3D trong phim ảnh và trò chơi điện tử. Các ứng dụng chỉnh sửa video chuyên nghiệp như Adobe Premiere Pro hay DaVinci Resolve cũng tận dụng CUDA để tăng tốc các tác vụ như xử lý hiệu ứng, ổn định hình ảnh và xuất video ở độ phân giải cao. Hơn nữa, CUDA còn là động lực đằng sau các ứng dụng thực tế ảo (VR) và thực tế tăng cường (AR), nơi việc render đồ họa phức tạp trong thời gian thực là yêu cầu bắt buộc để tạo ra trải nghiệm mượt mà và chân thực.

So sánh hiệu năng giữa CUDA và CPU truyền thống

Để hiểu rõ hơn về giá trị của CUDA, việc đặt nó lên bàn cân so sánh với CPU truyền thống là rất cần thiết. Cả hai đều là những bộ xử lý quan trọng, nhưng chúng được thiết kế với những triết lý khác nhau và tỏa sáng ở những loại tác vụ khác nhau.

Thế mạnh của CUDA trong các tác vụ song song

Thế mạnh tuyệt đối của CUDA và GPU nằm ở khả năng xử lý song song dữ liệu (data parallelism). Bất kỳ bài toán nào có thể được chia thành nhiều phần nhỏ, độc lập và xử lý đồng thời đều là “sân chơi” của CUDA. Một ví dụ kinh điển là phép nhân hai ma trận lớn. Với CPU, quá trình này sẽ được thực hiện tuần tự, tính toán từng phần tử một. Trong khi đó, với CUDA, hàng nghìn lõi GPU có thể tính toán hàng nghìn phần tử của ma trận kết quả cùng một lúc. Điều này tạo ra sự khác biệt về hiệu suất một cách rõ rệt. Tương tự, trong các lĩnh vực mô phỏng vật lý, phân tích tài chính, hay giải mã gen, nơi cùng một thuật toán cần được áp dụng cho một tập dữ liệu khổng lồ, CUDA luôn cho thấy hiệu năng vượt trội, giúp giảm thời gian tính toán từ hàng giờ xuống còn vài phút.

Hạn chế và khi nào nên ưu tiên dùng CPU

Tuy nhiên, CUDA không phải là giải pháp cho mọi vấn đề. Kiến trúc của GPU không được tối ưu cho các tác vụ tuần tự (serial tasks) hoặc các tác vụ đòi hỏi sự phân nhánh luồng điều khiển phức tạp. Ví dụ, các công việc như quản lý hệ điều hành, chạy các ứng dụng văn phòng, hay thực thi một đoạn mã có nhiều câu lệnh điều kiện if-else lồng nhau thường chạy hiệu quả hơn trên CPU. CPU có số lõi ít hơn nhưng mỗi lõi lại mạnh hơn nhiều, được trang bị bộ nhớ đệm (cache) lớn và được tối ưu hóa cho độ trễ thấp (low latency). Do đó, khi một tác vụ có độ phức tạp về logic cao nhưng không đòi hỏi xử lý lượng lớn dữ liệu song song, hoặc khi các bước trong quy trình phải thực hiện nối tiếp nhau, CPU vẫn là lựa chọn ưu tiên. Một hệ thống hiệu quả thường kết hợp cả hai: sử dụng CPU cho các tác vụ quản lý chung và tuần tự, đồng thời chuyển các phần tính toán song song chuyên sâu cho GPU thông qua CUDA.

Các lĩnh vực ứng dụng và phát triển CUDA hiện nay

Với sự phát triển không ngừng của công nghệ, CUDA đã vượt ra khỏi phạm vi học thuật và trở thành một công cụ không thể thiếu trong nhiều ngành công nghiệp, thúc đẩy những đột phá mang tính cách mạng và định hình lại cách chúng ta phát triển phần mềm.

Công nghiệp, nghiên cứu và giải pháp AI

Trong lĩnh vực công nghiệp và nghiên cứu, CUDA là động lực chính đằng sau nhiều tiến bộ vượt bậc. Ngành công nghiệp ô tô đang sử dụng CUDA để phát triển hệ thống xe tự lái, nơi GPU phải xử lý và phân tích dữ liệu từ hàng loạt cảm biến (camera, LiDAR, radar) trong thời gian thực để đưa ra quyết định an toàn. Trong y tế, CUDA giúp tăng tốc các thuật toán chẩn đoán hình ảnh, phát hiện sớm ung thư và mô phỏng tương tác thuốc, mở ra kỷ nguyên y học chính xác. Ngành tài chính cũng ứng dụng CUDA để thực hiện các mô hình định giá rủi ro phức tạp và giao dịch tần suất cao (HFT), nơi mỗi mili giây đều có giá trị. Các nhà khoa học cũng dựa vào CUDA để mô phỏng biến đổi khí hậu, nghiên cứu thiên văn và phân tích dữ liệu gen khổng lồ.

Phát triển phần mềm, game và đồ họa máy tính

Đối với các nhà phát triển phần mềm, game và đồ họa, CUDA mang lại khả năng tối ưu hóa hiệu suất ở một cấp độ hoàn toàn mới. Trong ngành công nghiệp game, CUDA không chỉ giúp render đồ họa chân thực với công nghệ ray tracing theo thời gian thực mà còn được dùng để mô phỏng các hiệu ứng vật lý phức tạp như chất lỏng, khói lửa và vải vóc, tạo ra một thế giới game sống động và tương tác cao. Các phần mềm đồ họa chuyên nghiệp như Blender, Autodesk Maya và V-Ray đều tích hợp CUDA để tăng tốc quá trình render, cho phép các nghệ sĩ và nhà thiết kế thấy được kết quả công việc của mình nhanh hơn rất nhiều. Ngay cả trong lĩnh vực phát triển phần mềm thông thường, các lập trình viên cũng có thể sử dụng CUDA để tăng tốc các module xử lý dữ liệu nặng trong ứng dụng của họ, mang lại trải nghiệm người dùng mượt mà và hiệu quả hơn.

Common Issues/Troubleshooting

Mặc dù CUDA là một công nghệ mạnh mẽ, nhưng trong quá trình triển khai và lập trình, người dùng có thể gặp phải một số vấn đề phổ biến. Hiểu rõ những thách thức này sẽ giúp bạn khắc phục sự cố một cách hiệu quả hơn.

Vấn đề tương thích phần cứng và phần mềm

Một trong những vấn đề đầu tiên mà người mới bắt đầu thường gặp là tương thích. Điều quan trọng cần nhớ là CUDA chỉ hoạt động trên các GPU của NVIDIA. Nếu máy tính của bạn sử dụng card đồ họa từ nhà sản xuất khác (như AMD hay Intel), bạn sẽ không thể sử dụng nền tảng CUDA. Một vấn đề phổ biến khác là driver GPU đã lỗi thời. NVIDIA thường xuyên phát hành các phiên bản driver mới để sửa lỗi, cải thiện hiệu suất và hỗ trợ các tính năng CUDA mới nhất. Việc không cập nhật driver có thể dẫn đến lỗi khi chạy ứng dụng hoặc hiệu năng không đạt như mong đợi. Ngoài ra, cần đảm bảo rằng phiên bản CUDA Toolkit (bộ công cụ phát triển) mà bạn cài đặt tương thích với phiên bản driver và hệ điều hành của bạn.

Lỗi lập trình CUDA phổ biến

Đối với các lập trình viên, có một số lỗi kinh điển cần lưu ý. Một trong số đó là “deadlock” (khóa chết), xảy ra khi các luồng (threads) trong các khối (blocks) khác nhau cố gắng đồng bộ hóa với nhau, hoặc khi chúng chờ đợi một tài nguyên mà không bao giờ được giải phóng. Việc quản lý bộ nhớ không hiệu quả cũng là một nguyên nhân gây lỗi và làm giảm hiệu suất. Ví dụ, việc lạm dụng bộ nhớ toàn cầu (global memory) có tốc độ truy cập chậm thay vì tận dụng bộ nhớ chia sẻ (shared memory) nhanh hơn có thể khiến ứng dụng chạy ì ạch. Một lỗi khác là “race condition”, xảy ra khi nhiều luồng cố gắng đọc và ghi vào cùng một vị trí bộ nhớ mà không có cơ chế đồng bộ hóa phù hợp, dẫn đến kết quả sai và không thể đoán trước.

Best Practices

Để khai thác tối đa sức mạnh của CUDA và xây dựng các ứng dụng hiệu năng cao, ổn định, việc tuân thủ các phương pháp hay nhất (best practices) là vô cùng quan trọng. Những nguyên tắc này giúp tối ưu hóa từ phần cứng đến phần mềm.

Đầu tiên, hãy sử dụng bộ nhớ một cách hiệu quả. Đây là chìa khóa để đạt được hiệu suất cao. Ưu tiên sử dụng bộ nhớ chia sẻ (shared memory) và thanh ghi (registers) càng nhiều càng tốt, vì chúng có tốc độ truy cập nhanh nhất. Hạn chế tối đa việc truy cập vào bộ nhớ toàn cầu (global memory) vốn có độ trễ cao. Cố gắng tổ chức các truy cập bộ nhớ toàn cầu theo kiểu “coalesced”, nghĩa là các luồng trong cùng một warp (một nhóm 32 luồng) truy cập vào các vị trí bộ nhớ liền kề nhau. Điều này cho phép GPU gộp nhiều yêu cầu truy cập thành một giao dịch duy nhất, giúp tăng thông lượng bộ nhớ.

Thứ hai, tối ưu hóa việc thực thi kernel. Tránh tạo ra các thread không cần thiết, vì mỗi thread đều tiêu tốn tài nguyên. Đảm bảo rằng khối lượng công việc được phân bổ đều cho các thread để tránh tình trạng một số thread đã hoàn thành trong khi những thread khác vẫn đang bận rộn. Một yếu tố quan trọng khác là tránh sự phân nhánh (divergence) trong một warp. Nếu các luồng trong cùng một warp đi theo các nhánh if-else khác nhau, GPU sẽ phải thực thi cả hai nhánh một cách tuần tự, làm mất đi lợi thế song song. Cuối cùng, một quy tắc vàng là luôn cập nhật driver GPU và bộ công cụ CUDA SDK lên phiên bản mới nhất. NVIDIA liên tục cải tiến trình biên dịch, thư viện và công cụ gỡ lỗi, giúp ứng dụng của bạn chạy nhanh hơn và ổn định hơn mà không cần thay đổi mã nguồn.

Kết luận

Qua những phân tích chi tiết, có thể thấy CUDA không chỉ là một công nghệ mà là một cuộc cách mạng trong lĩnh vực tính toán hiệu năng cao. Bằng cách cho phép chúng ta khai thác sức mạnh xử lý song song khổng lồ của GPU, CUDA đã phá vỡ những giới hạn của CPU truyền thống. Những điểm chính cần nhớ là CUDA giúp tăng tốc xử lý vượt trội cho các tác vụ song song, đóng vai trò nền tảng cho sự phát triển của trí tuệ nhân tạo, và mở ra vô số ứng dụng đột phá trong xử lý hình ảnh, mô phỏng khoa học và đồ họa máy tính. Việc hiểu rõ cơ chế hoạt động, lợi ích và cả những hạn chế của nó giúp chúng ta đưa ra lựa chọn công nghệ phù hợp và hiệu quả nhất cho từng bài toán cụ thể.

Nếu bạn đang làm việc trong các lĩnh vực đòi hỏi khả năng tính toán chuyên sâu, từ phân tích dữ liệu, machine learning đến phát triển game, đừng ngần ngại tìm hiểu thêm về lập trình CUDA. Việc trang bị kỹ năng này sẽ giúp bạn nâng cao hiệu năng dự án, rút ngắn thời gian phát triển và mở ra những khả năng sáng tạo mới. Hãy bắt đầu hành trình của mình bằng cách tham gia các khóa học lập trình CUDA trực tuyến hoặc thử nghiệm với các thư viện phổ biến được tăng tốc bởi CUDA như TensorFlow, PyTorch, hay OpenCV. Khai phá sức mạnh của GPU ngay hôm nay để sẵn sàng cho tương lai của công nghệ.